基于RGB和深度图像的中底层特征研究保持语义信息的多模态特征关联表达,是融合RGB-D数据进行人体行为识别的研究热点。因此,联合特征表达模型也可以视为是一种多模态特征的联合表达模型。而已有的子空间学习方法大都缺乏对上述两种空间结构关系的嵌套,使得学习的多模态特征表达不能充分保持原始数据中蕴含的几何结构,从而降低了多模态特征联合表达后的描述能力。

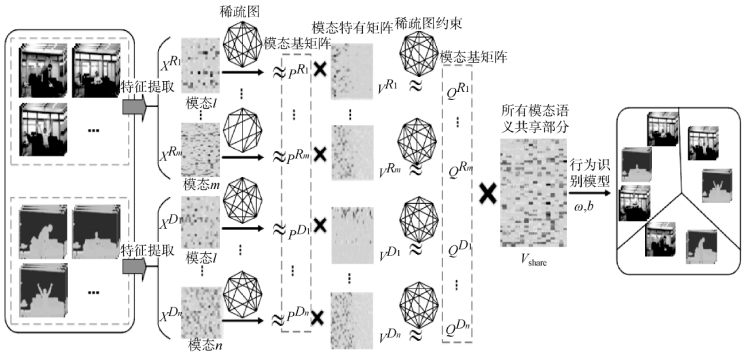

本节将稀疏图表示技术与非负矩阵分解算法相结合,介绍基于多个稀疏图正则约束与双层非负矩阵分解模型(Multiple Sparse Graph Regularized Double Nonegative Matrix Factorization,MSG-DNMF)的多模态特征联合表达方法。该算法的框架图如图4-17所示。MSG-DNMF结合使用三种样本数据信息:样本的类别信息,同一模态数据下样本的相似度,不同模态数据之间样本的相似度,来构建样本之间不同的图结构。具体地,首先在每个模态特征空间中,将每个样本数据看成是剩余所有样本的稀疏表示,并基于得到的稀疏表示系数和样本的类别关系信息构建样本之间的图邻接矩阵;其次,根据任意两个模态特征空间下图的结构相似度建立样本在它们之间的语义关系图;同时对各模态特征下的邻接矩阵进行整合得到样本在所有模态数据上的邻接关系图。然后将上述构造的图邻接矩阵作为正则项加入多模态特征数据的双层非负矩阵分解模型中,得到既能保持各模态数据原始几何结构又能保持多模态特征语义一致性的联合表达。最后基于获得的联合表达用于RGB-D人体行为识别。实验证明,该方法不仅能有效学习不同模态特征的联合表达,也能学习单一模态下多个视觉特征的融合表达。

(https://www.xing528.com)

(https://www.xing528.com)

图4-17 本节所提的基于MSG-DNMF算法的多模态特征表达模型及行为识别流程图

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。