本节对片段-视频级特征融合算法和视频关键帧选取算法在当前公开的行为数据集UCF-101和HMDB-51上,进行相关的实验验证和分析,包括自身有效性验证和整体识别方法的对比,具体的实验结果和分析如下。

1.时域输入特征有效性实验

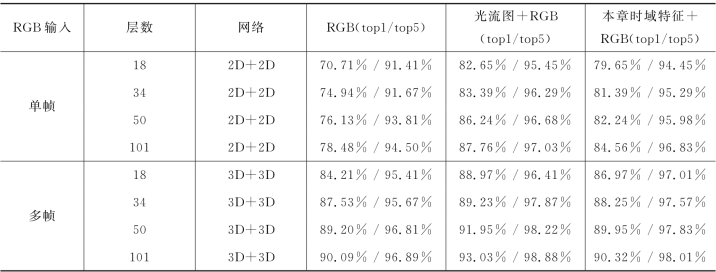

时域输入特征基于背景剪除算法,一方面在提取时间损耗的优势在4.2.1中已经通过实验阐述,另一方面为识别框架引入显性的时域运动描述。因此,为验证时域输入特征序列对于整体识别准确率的影响,使用双流卷积的识别框架对其性能进行分析。实验测试了双路二维卷积网络和双路三维卷积网络两种框架。其中,双路二维卷积网络的局部空域分支输入为从视频帧序列中随机抽选的一帧,时域分支的输入为随机抽取的视频片段、光流图和本节时域输入特征片段。而双路三维卷积网络的局部空域分支输入为视频帧片段,且两路均为三维卷积网络,两种框架的网络结构均为残差结构,分别测试了在不同深度网络(18,34,50,101)上的识别准确率差异,结果如表4-3所示。

表4-3 时域输入特征有效性验证实验结果

由表4-3的结果可以看出,首先对于每一种框架而言,随着网络的深度增加,各类输入下框架的识别性能(top1准确率和top5准确率)均呈现增加的趋势,同时双流三维卷积的框架性能整体识别性能均优于二维卷积网络,一方面由于三维卷积网络本身的参数量更大,其理论上的拟合能力更强。另一方面,三维卷积网络的输入均为视频帧序列,结合三维卷积结构在时序特征提取的优势,能更好地挖掘视频数据中的时空特征,因此其性能高于二维卷积网络。其中,重点观察到相比单独的RGB输入,同等深度网络下,RGB+时域输入特征的识别准确率均有明显的提升,可以推断出时域输入特征序列引入的显性轮廓和运动信息,对于提升识别准确率的有效性。同时,对比RGB+光流和RGB+时域输入特征两种输入的性能差异,RGB+光流的方法在top1准确率和top5均有一定的优势。原因主要在于光流图的计算为稠密计算,对于运动的捕捉粒度更细,同时时域输入特征侧重于对背景相对稳定的动作类别。但是光流图带来的计算负担过重(表4-1),结合时域输入特征top5准确率与光流图较为接近,且在提取时间损耗较小这两个因素,时域输入特征为有效的快速时域运动辅助特征,验证了其对于提升视频行为框架识别准确率的有效性。

2.视频级全局时域特征分析

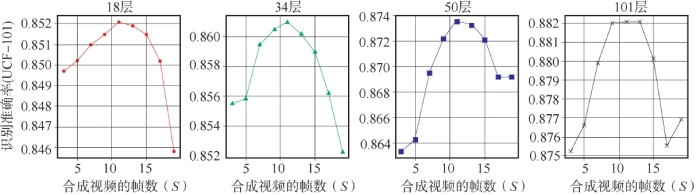

在对全局时域信息聚合生成历史轮廓图像时,对时域输入特征序列进行时序抽样实验。设置了不同的时间间隔来进行抽样,不同的时间采样间隔决定了全局时域特征描述的稀疏性。时间间隔过大会导致动作的关键信息缺失严重,而过小的时间间隔则难以抽象动作的历史轮廓,造成历史轮廓图像的模糊或信息不足。因此,合适的时间采样间隔成为历史轮廓图像提升识别性能的关键。基于此,构建实验评估不同时间采样间隔的效果差异,将历史轮廓图像、原始的RGB图像和时域输入特征序列分别输入到各自的分支卷积网络进行训练,采样使用4.2.1节中提出的全视频范围内均分的算法,在UCF101数据集上不同网络深度的结果如图4-9所示。

图4-9中S为合成历史轮廓图像的帧数,即从每个动作的全视频范围内等间隔抽取对应的帧数,以此保证采样的时间跨度可以覆盖不同时长的视频。由图4-9可以看出,不同深度网络下的识别框架均呈现出相似的识别性能变化趋势,即在合成帧数为11~12时识别准确率达到最高,以此为界限合成的帧数较少或较多时,框架整体的识别准确率均有下降。为了最大程度减少在聚合时的计算资源消耗和时间,全局时域信息聚合的方法从视频范围内快速聚合为一张图像时,聚合信息的密度直接由叠加帧数决定,过于稀疏的采样导致补充的全局信息不足,性能提升有限。对于过于稠密的采样,由于单张图像空间的有限和部分动作背景变化较大,对全局信息的叠加干扰较为严重,影响全局信息的准确表达。因此,综合该实验结果,后续实验采用的历史轮廓图像均由11个视频帧合成。

图4-9 历史轮廓时间间隔选取对比实验结果

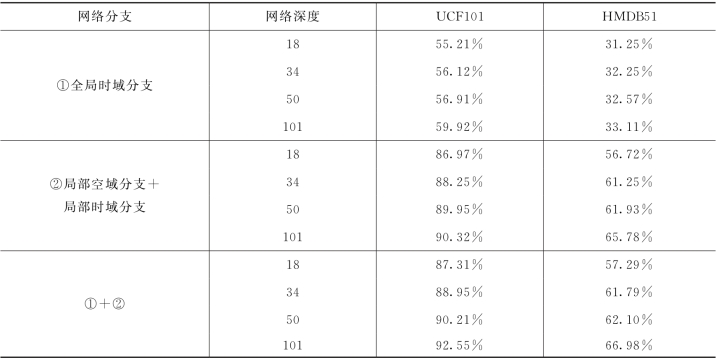

为了进一步分析历史轮廓图像对于识别性能的影响,在不同深度(18、34、50、101)的三维卷积网络框架下,分别实验全局时域分支、局部空域分支+局部时域分支和融合三个分支,其在UCF-101和HMDB-51数据集上的视频级准确率结果如表4-4所示。首先在各个处理分支识别准确率均随着卷积网络的深度增加而提升,验证了各类输入特征输入在不同深度网络下的性能稳定。由于时域输入特征方法在背景变化较小的行为视频上有更好的辅助效果,且历史轮廓图像的全局时域信息本身是作为时空分支的全局时空信息补充,因此只输入历史轮廓图像的全局时域分支识别准确率相对较低,但是在结合了局部空域分支和局部时域分支后,相比单独的各个分支,在UCF-101和HMDB-51两个数据集上,整体的识别准确率都有明显的提升,说明历史轮廓图像带来了局部时域和空域分支缺少的全局信息,通过补充更大时域视野的信息可以提升对行为的辨别能力,也验证了全局的时域特征聚合对于提升行为框架识别准确率的有效性。

表4-4 历史轮廓图像有效性验证实验结果

3.关键片段有效性实验(https://www.xing528.com)

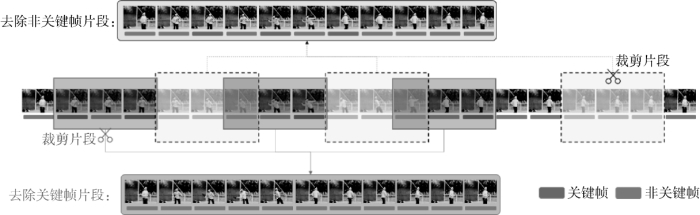

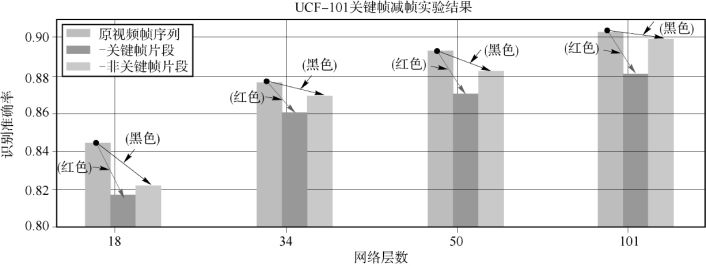

为了验证基于时序梯度分析关键帧选取算法的有效性,首先分析算法选取关键帧的时域关键性。对于UCF-101数据集中的视频进行关键帧输入减帧实验,即将本节算法生成的关键帧索引作为采样锚点和随机非关键帧索引作为采样锚点,分别从原视频帧序列中裁去以锚点为中心的前后时域片段(16帧),生成原视频序列的子序列作为输入,如图4-10所示。因此,处理后可以获得三种输入序列:原始视频帧序列、去除关键帧片段视频帧序列和去除非关键帧片段视频帧序列,在三维卷积网络上实验其识别准确率的衰减差异,如图4-11所示。

图4-10 关键帧有效性验证实验关键帧处理图

图4-11 关键帧减帧实验结果图(UCF-101数据集)

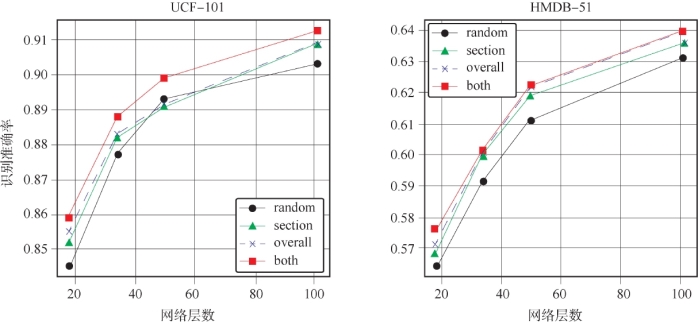

关键帧中的关键信息对于识别起到更重要作用,即在输入层面具有更多时空特征编码与判别时的关键信息,因此理论上去除关键信息后,识别性能应该有明显的下降。由图4-11可以看出,在对原视频帧序列中去除掉一部分数据后,在不同深度的网络上识别准确率均有不同程度的下降(图中的红色和黑色箭头),其中去除关键帧片段的准确率下降比去除非关键帧片段更为显著,即关键时域对识别准确率的贡献更大,由此验证了算法选取的关键帧中包含有更为显著的辨别性时域信息。进一步使用关键帧选取算法生成的两种关键视频片段和单纯输入随机抽取的视频片段的方法,在UCF-10与HMDB-51数据集上进行识别准确率的实验对比。主体识别网络均使用不同深度的三维残差网络(18,34,50,101),在基础分支上单独融合分段式关键分支、单独融合汇总式关键分支和同时融合两种分支的识别准确率,结果如图4-12所示。

图4-12 输入随机片段和关键片段对比实验结果

(random:随机片段;section:融合分段式分支;overall:融合汇总式分支;

both:同时叠加分段式分支和汇总式分支)

由图4-12中可以看出,随着三维卷积网络深度的增加,在两个数据集上四类输入方式(随机片段、分段式关键片段、汇总式关键片段和同时融合两种片段)的识别准确率都逐步上升。同时在同等深度的三维网络上,相比只输入随机抽取生成的视频片段,分别融合输入算法生成的分段式关键片段和汇总式关键片段的准确率均有提升,且汇总式比分段式整体上更高。原因在于,随机训练过程中使用随机离散的采样锚点结合连续片段的方法,即时域输入为随机局部时域,分段式关键片段为关键局部时域,而汇总式关键片段为关键全局时域。相较于关键局部时域,全局时域引入的信息差更大,强化关键帧信息的同时补充了更大时域视野的信息。由此验证了关键片段对于提升整体识别准确率的有效性。进一步观察,同时叠加两种关键片段训练时,整体识别准确率的提升可以最大化。

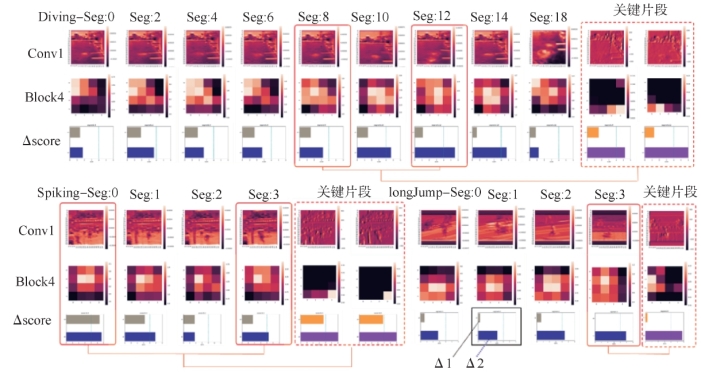

通过对深度网络中浅层网络和深层网络特征可视化的样例结果进行分析(图4-13),由浅层特征图可以看出,对于空间纹理的可描述性比较强,而深层的特征图在经过逐层的卷积拟合后,不具备直观的空间描述性,推断其时空信息通过网络完成融合。非关键片段的深层特征图在不同片段输入时,有相似的可视化分布,而关键片段训练后的深层特征图的分布有显著差别,表明网络深层拟合后的时空特征有一定程度的差异。为了验证对于行为判别时置信度的确定性,在识别正确的前提下,观察识别结果的置信分数中,最高置信度打分与次高、第三高的置信分差(Δ1=max1-max2,Δ2=max1-max3)。分差越大,即判别时,网络对于不同行为类间差异的辨别能力越强。由图4-13结果可以看出,对应的关键片段训练后,不同类别上置信分差都有进一步的提升,因此网络对于动作的时空辨别能力得到增强。

图4-13 深度网络层间特征可视化分析

Seg为各个视频片段;Conv1为网络浅层卷积后的特征图;Block4为网络深层特征图;Δscore=(Δ1,Δ2)中Δ1=max1-max2为每个片段识别后最高置信度和次高置信度的差值,Δ2同理。(UCF视频样例:Diving,VolleyballSpiking,long Jump)

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。