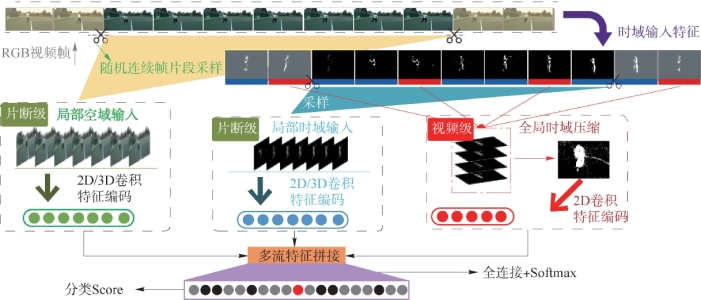

深度卷积框架在处理视频数据时,由于视频时域长度的不确定性,输入识别网络的是行为视频的一个局部片段,即框架对连续的局部时域行为特征进行判别,缺少视频的全局时域信息。同时光流图作为主要的时域辅助输入特征,其提取需要耗费大量的计算资源。针对以上问题,本节在引入基于背景剪除的时域输入特征序列基础上,构建视频-片段不同时域尺度输入采样处理的算法,提出基于片段-视频级特征融合输入的行为识别框架,如图4-2所示。框架从原始RGB序列和时域输入特征序列两个数据上,采样生成不同时域尺度的输入片段:局部空域纹理特征(RGB视频帧/片段)、局部时域运动特征(时域输入特征序列片段)和全局时域运动特征(历史轮廓图像),以此在输入层面聚合不同时域尺度的信息。识别框架一方面有细粒度的片段级行为时空特征提取分支,另一方面有包含全局时域信息的粗粒度视频级时域识别分支。识别网络方面,局部分支采用三维残差卷积网络;由于全局时域信息聚合后为二维图像,该分支采取轻量级的二维卷积网络。

图4-2 基于片段-视频级特征融合输入的行为识别框架图

1.视频时空输入分析

双流行为识别框架中,一般分为视频输入阶段和网络识别阶段,其中视频输入阶段生成各类输入特征,即在进入识别网络前,提前对输入视频数据进行选择和处理。当识别模型为卷积网络时,原始的视频帧序列难以快速表达动作显性的时域运动特征,因此一般在输入阶段将原始的视频数据I3D∈R w×h×m按照时空拆分为:时域运动输入特征IT∈R w′×h′×m和空域纹理输入特征Is∈R w×h×m′。其中m为视频序列的总帧数,w×h为原始视频图像的空间尺寸,w′×h′为时域输入特征的空间尺寸,m′为空域纹理输入特征的时间尺寸(帧数)。空域纹理输入特征Is会对时域信息进行压缩或弱表达,如从视频片段中抽取一帧图像等。而时域运动输入特征IT表示对原始视频数据进行运动信息的抽取,典型为光流,但是光流处理时对全图进行了密集运动信息计算,导致计算量和时间损耗较大,因此本节引入非密集的基于背景减除的时域输入特征,以此节省识别时间。

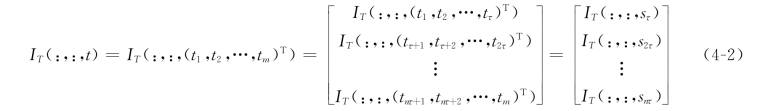

在时域采样时,完整的时域输入特征IT(x,y,t)∈R w′×h′×m覆盖整个视频时间t∈R1×m,由于不同视频的时长具有不确定性,因此在输入卷积网络时,需要对时域进行分段处理,按照固定长度的局部时域分段得到snτ∈R1×τ:

![]()

式中,sτ=(t1,t2,…,tτ)T,s2τ=(tτ+1,tτ+2,…,t2τ)T,…,snτ=(tnτ+1,tnτ+2,…,tm)T,n为视频对应的分段数,τ为视频片段的固定时域长度(τ<m),基于该时域分段后的完整时域输入特征IT(:,:,t)∈R w′×h′×m表示为

式中,IT(:,:,snτ)∈R w′×h′×τ为基于局部时域片段的时域输入特征。卷积网络难以将视频的全部时域直接覆盖,而是将多个局部时域编码f Conv Net后生成的置信向量scoren∈R 1×class(其中class为分类结果中的类别数)通过向量的叠加平均融合,来逼近全局时域编码的结果。融合后获得视频识别的置信向量score∈R 1×class即

局部时域分段IT(:,:,snτ)对时域分段后,全局时域输入变为局部时域的拼接,缺少直接的全局时域信息和片段之间的编码,增加了学习时样本的类内学习难度。因此,为了进一步优化对于全局时域编码的近似,本节引入全局时域的辅助输入特征I′∈R w′×h′,由全局时域特征算法合并而成,经由单独的卷积网络进行编码f Conv Net2,输出的置信向量进一步融合后得到score′∈R 1×class为

即在局部时域输入的基础上,进一步融合基于全局时域的输入特征。

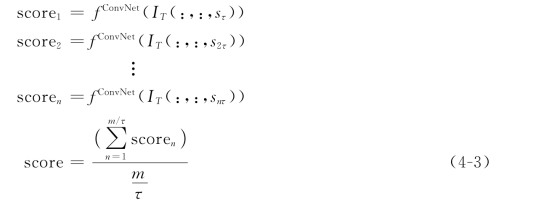

2.时域输入特征生成

对于二维卷积网络,空域输入特征一般从视频中随机抽选一帧作为输入,而对于三维卷积网络而言,则输入视频片段的RGB图像序列。当前典型的时域运动输入特征主要为光流图,但是光流本身的提取时间复杂度较高,即使在GPU上进行计算也难以达到实时部署的要求。由于时序运动输入特征要显性地突出视频中目标的运动变化,即突出运动本身,弱化背景的干扰。因此基于提取复杂度更低的背景剪除方法,通过算法生成时域输入特征来代替光流图。

3.输入特征提取时耗对比

引入基于背景剪除算法的时域特征,主要目的是为了降低识别在输入阶段提取时间的损耗,以此来代替双流框架中的光流图。在图像处理的速度方面,将提取光流和背景剪除的算法在CPU和GPU上进行对比实验。使用当前应用较为广泛的MOG、MOG2、GMG和KNN的背景剪除算法,与其他目前典型的光流提取方法Flownet等进行速度对比,结果如表4-1所示。对于矩阵计算,GPU(GTX-645)的计算速度远高于CPU,而表4-1可以看出在CPU上进行的背景剪除速度远高于GPU上的光流提取,由此验证了引入背景剪除方法代替光流在提取速度上的优势,可以为识别框架在输入阶段的特征提取节省时间。

表4-1 背景剪除和光流提取速度对比实验结果

(https://www.xing528.com)

(https://www.xing528.com)

4.时域输入特征生成

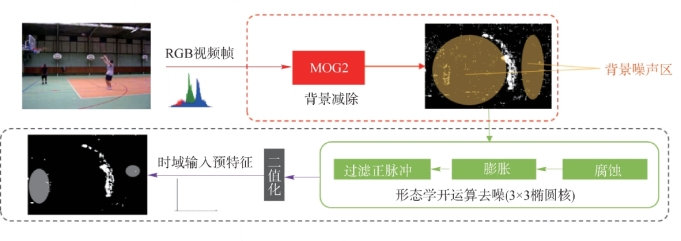

生成时域输入特征时,利用背景剪除来弱化背景噪声对识别的干扰,突出运动目标本身。首先,将原始视频转换为RGB图像序列。其次,利用背景剪除的算法来处理RGB原始序列得到背景剪除后的图像序列,如图4-3所示。背景剪除算法方面,使用基于混合高斯模型MOG2的背景建模方法来完成背景剪除。经背景剪除处理后的图像仍有一定程度的散点噪声,为了最大程度地消除散点噪声对识别的影响,将去噪过程扩展到背景剪除后的图像序列,并进行二值化处理,以此得到最终的时域输入特征序列。

图4-3 时域特征生成算法框架

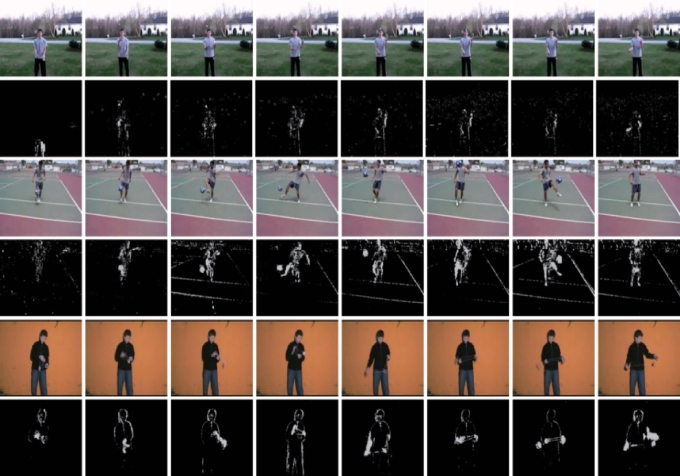

卷积网络对单帧静止图像的空域纹理特征具有很好的特征提取能力,但难以直接从多帧图像中提取时域和空域组合的特征。因此在输入层面,需要降低特征的学习难度,即显性突出关键的运动信息,减少背景等噪声的干扰。经过时域输入特征算法处理后的特征序列,对于背景相对稳定的动作,可以有效地去除背景干扰和不相关的纹理特征,只保留动作目标的运动和轮廓信息,如图4-4所示,以此减弱时域运动特征的学习难度。

时域输入特征处理后(图4-4),视频帧间固定的背景和静态的物体部分被弱化,去除彩色空间,重点保留视频中发生运动漂移部分的二值化轮廓,以此突出时域上行为运动的变化。视频中背景变化越小,特征对运动模态的突出越清晰。

图4-4 时域输入特征处理效果示例图(UCF-101:JugglingBalls,SoccerJuggling and Yo Yo)

5.视频级全局时域特征

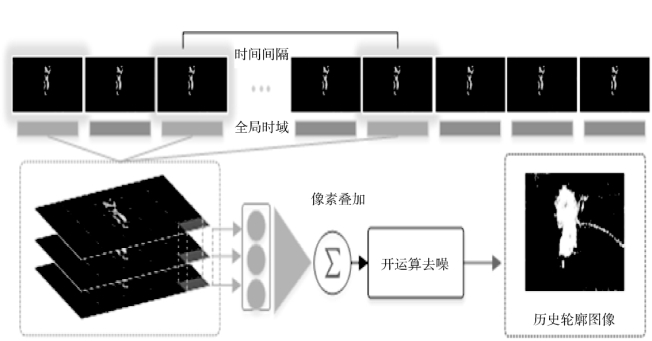

由于卷积网络的输入维度是固定的,网络单次识别的输入是一个动作的视频片段而非整个视频,所以动作由连续的短时局部片段来描述时,会损失全局时域的长时信息。同时,如果直接提升卷积网络的输入时长至整个视频范围,一方面会引发模型计算量的剧增,另一方面也难以对所有时间跨度的动作进行覆盖识别,不具有通用性。因此,为了更好地描述动作整体的类间差异并聚合视频的全局时域运动信息,按照一定的时间跨度对时域输入特征序列进行全视频范围的采样聚合,通过迭加计算视频帧上对应的空间像素值,来生成历史轮廓图像。

图4-5 全局时域生成历史轮廓图流程框架

最后,对历史轮廓图像进行二值化处理,获得更为简洁的特征表达,具体框架如图4-5所示。同时由于历史轮廓图像可以被任意数量的图像叠加,卷积网络可以借此粗粒度地学习任何时间尺度的信息,从而利用视频级尺度的信息提升整体识别的性能。由于视频转换为图像序列后,存在大量的相似冗余帧,为了提升历史轮廓图像的清晰程度和辨别性,设置不同的时间间隔进行采样叠加。由于每个视频的时长不确定,因此对应生成的视频帧数也不同。为了保证生成的历史轮廓图像可以覆盖整个视频时间范围,首先获得整个行为视频的总帧数,再按照要合成的帧数计算对应的采样时间间隔。即某视频的总帧数为nframe,设定将视频内的S帧合并生成历史轮廓图像,则采样时的时间间隔Interval:

![]()

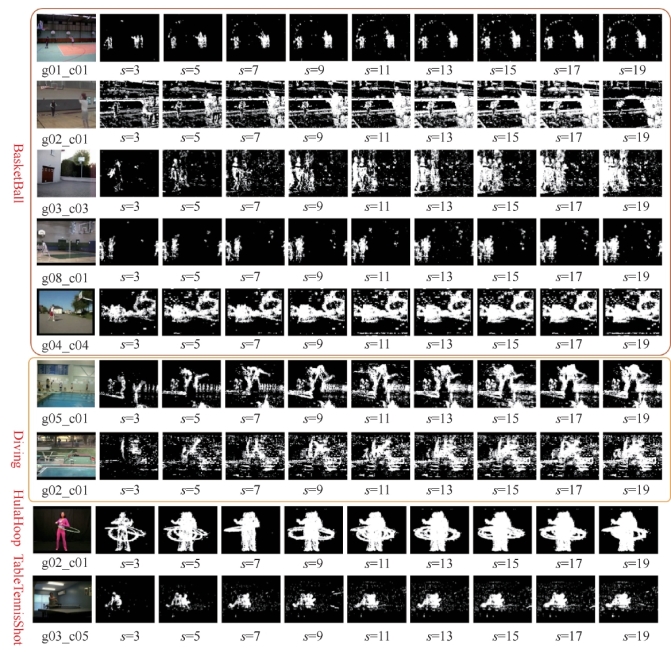

为保证去除视频末端部分无效帧,实际计算时将总帧数nframe减去e帧(本节取e为2)。根据该采样方法,对UCF-101数据集进行采样将不同视频帧合并生成历史轮廓图像,效果如图4-6所示。

图4-6 历史轮廓图示例效果

S为合成历史轮廓图像的帧数,样例来自

UCF-101:Basketball、Diving、Hula Hoop、TableTennisSwing

由图4-6所示,生成的历史轮廓图像随着合成帧数S的增加,图像上叠加的信息也逐渐增加,将不同时序下的动作合并显示到一张图像中。同时,观察到当S较小时,历史轮廓图像上的信息叠加较为稀疏,但是当S较大时,有限的空间里有更多的动作信息被同时叠加,导致历史轮廓图像效果比较模糊。因此,选择合适的叠加帧数,对历史轮廓图像的效果至关重要。当合成的帧数到达一定数量后,历史轮廓图像的变化开始减小。同时对于同一动作而言,例如Basketball:g01_c01片段由于背景相对稳定,经过背景剪除的图像质量较为稳定,历史轮廓图像的效果也较好。而片段g04_c04的背景不稳定,导致历史轮廓图像的叠加显示效果不佳,因此历史轮廓图像对于背景变化较小的视频有更好的叠加效果。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。