随着广电行业的数字化、高清化、网络化的发展,我国广播电视的IT化水平在不断提高,各级电视台已经建成制作网络、播出网络等各种网络,也正在开始建设全台网。网络规模越来越大,网络结构越来越复杂,随着高清节目制作技术和全媒体业务的高速发展,电视节目制播分离、三网融合等网络业务需求越来越多元化。

网络制播之所以能够发挥资源共享、并行工作等作用,关键在于网络平台,其中网络架构是核心,网络架构将随着应用需求的变化进行不断的优化。

1.网络架构

主要有:基于FC+以太网的双网结构,基于纯以太网的单网结构,基于私有协议的分布式存储系统。

(1)基于FC+以太网的双网结构

为了满足海量视音频素材数字化存储和再利用的需求,存储区域网(Storage Area Network)技术在广播电视行业得到广泛应用。最早的SAN是基于SCSI协议的小型系统,但受到SCSI协议的寻址空间、传输距离、安全机制等方面的限制,很快就被基于FC的SAN取代。

在视音频应用中,一个重要特点就是共享。为保证共享管理软件正常运行,在建立FC网络时,还需建立以太网用于传递控制信息。同时,视音频编辑软件、媒体资产管理软件也都需要通过以太网去访问中心数据库。这就是所谓的双网结构,它由基于FC协议的光纤通道网和基于TCP/IP协议的以太网组成,其中以太网主要传送控制信息和数据库信息,FC网络主要传送高码率的视音频数据。

双网结构的优点:

①高性能。基于FC+以太网的双网结构系统,其最大的优点在于高性能,可以在大数据量并发访问情况下保证稳定的主机读写带宽。目前,常见的2Gb的光纤通道已经可以提供200MB/S的读写带宽。4Gb和8Gb的产品也已经投入使用。

②FC-SAN技术成熟。经过多年的发展,各品牌以FC-SAN为基本架构的非编网络已逐渐趋于成熟,现如今在各中小电视台都得到了实际节目制作的检验。

③良好的平台。双网结构是我国视频行业的一个创举,不但有利于后期制作,还有利于开展从设备管理到媒体资产管理等综合媒体业务的管理,是电视台理想的媒体管理平台。

双网结构的缺点:

①造价高昂。在双网结构中,需要配备FC交换机、为主机端安装FC HBA卡、为工作站铺设光纤、安装SAN文件共享系统软件等,其造价比以太网高出数倍甚至十几倍,大规模部署的成本较高。

②互联互通存在难度。虽然光纤通道技术有统一的标准,但各家厂商却有不同的解释。各品牌FC-SAN非编网络互操作性差,用户在实际使用中,经常被一些不兼容性问题困扰,给互联互通制造了许多阻碍。

③传输距离有限。FC-SAN的传输距离通常不超过50公里。因此,FC-SAN还不能有效地整合更多的主机与存储的需求。

④光纤通道网络管理较复杂。由于引入了很多新概念、新技术,网络管理人员在学习和掌握时会遇到很多困难。

尽管如此,由于电视台视音频数据量巨大,制作网络对存储容量和带宽的要求较其他行业较高,因此,FC+以太网双网结构仍然是应用广泛、技术成熟度较高的实现方式。在全台高清制播网络建设阶段,双网结构仍然是主要采用的网络架构。

(2)基于纯以太网的单网结构

随着计算机技术和网络技术日新月异的发展,特别是千兆/万兆以太网技术的成熟、芯片处理能力的提升、iSCSI等相关标准的制定,一种面向视音频应用的基于纯以太网的单网架构解决方案应运而生,并在国内外众多项目中得到了广泛应用。

基于以太网的单网结构,各业务板块之间的媒体文件交换通过以太网进行,板块之间的耦合度低,通用性好,基于通用的网络和文件传输协议,容易实现多厂商、跨平台的文件交换,安全性高,FTP协议可以保证传输过程中文件的完整性,并且支持多种安全性设置,性能高,可以由多有FTP服务器并行提供文件传输服务,从而实现整体性能的水平扩展,同时还易于维护,以太网技术相对成熟,其网络管理维护也更简单。但单网结构也存在一定的缺点,比如稳定性、实时性稍差。

基于纯以太网的制播网络解决方案主要包括NAS技术、iSCSI技术等。

这种网络架构的特点是所有客户端工作站或服务器都通过千兆或百兆以太网(使用双绞线)访问共享的存储池,在存储服务器端会有一个小规模的SAN环境用于核心设备之间的高速连接。

①NAS

NAS(Network Access Storage,网络连接存储)是一种比较传统的存储方式,即将存储设备连接到现有的网络上,提供数据和文件服务,是一种网络文件系统服务器。它的典型组成是使用TCP/IP协议的以太网文件服务器,由工作站或服务器通过网络协议(如TCP/IP)和应用程序(如网络文件系统NFS或者通用Internet文件系统CIFS)来进行文件访问。NAS可以直接安装到已经存在的以太网中。NAS支持的网络文件协议通常有NFS和CIFS,也有HTTP、数据快照、备份服务等,与基于通用服务器的文件服务器不同,NAS系统不允许安装和运行其他任何应用程序。

基于NAS的网络存储技术出现的比FC-SAN早,但其最大的问题在于NAS头通过NFS或CIFS协议进行网络文件共享时效率较低,且难以保证稳定的带宽,最初的NAS根本无法满足视音频系统对带宽的要求。随着千兆以太网技术的发展和TOE(Tcp Offload Engine)网卡的出现,现在的NAS设备已经可以满足小规模制作系统的业务需求了。TOE网卡可以将传统上维持网络连接时由CPU负责的TCP/IP协议的封包拆包、检验运算等工作转移到网卡上由专用处理芯片完成,这样可以大幅降低系统资源占用,提高了网络带宽利用率。

在一般的制作网络的实际应用中,是既包含FC-SAN架构,又包含NAS架构。NAS解决方案的优点包括系统的易用性和可管理性;数据共享颗粒度细;共享用户之间可以共享文件级数据;适用于数据长距离传送环境。而缺点则是系统的可扩展性差,特别是整个系统的瓶颈局限于提供文件共享的NAS头处理能力。

NAS和SAN既存在区别,也是互补的存储技术。SAN将数据以块为单位进行管理,采用具有更高传输速率的光纤通道(Fibre Channel)连接方式和相关基础结构。它的设计和实现途径为它带来了更高的处理速度,而且SAN还是基于自身的独立的网络。它允许数据流直接从主网络上卸载,并降低了请求响应时间。与SAN相比,NAS支持多台对等客户机之间的文件共享,NAS客户机可以在企业中任何地点访问共享的文件。因为在NAS环境中文件访问的逻辑卷较少,对于响应时间要求也不是很高,所以其性能和距离要求也相对较低。

在存储方式上,除了NAS和SAN,还有DAS(Direct Attached Storage,直接连接存储)。

在制作网络的实际应用中,既有FC-SAN架构又有NAS架构。

②iSCSI

2003年2月,IETF(Internet Engineering Task Force,互联网工程任务组)通过了由IBM和Cisco共同发起的iSCSI(Internet Small Computer System Interface)标准,使这项历经三年、20个版本不断完善的技术标准终于被认可。所谓iSCSI就是将SCSI命令打在IP(IP Storage)包中传送给存储设备,以进行数据块的存取。其实质是实现了基于TCP/IP网络传输SCSI指令,也就是说SCSI over IP。iSCSI协议定义了在TCP/IP网络发送、接收block(数据块)级的存储数据的规则和方法。如图9-6所示为iSCSI协议的帧格式。

图9-6 iSCSI帧格式

iSCSI协议的实质是实现了基于TCP/IP网络传输SCSI指令,即SCSI over IP,通过iSCSI协议可以实现对存储设备的数据块级共享访问。

在一个iSCSI网络中,至少由iSCSI Target和iSCSI Initiator两部分组成,其中客户端需要安装iSCSI Initiator,由它向iSCSI Target所在的IP地址的指定端口发起连接,存储设备上安装iSCSI Target,它在特定端口监听到连接后进行握手判断,最终创建出一条在TCP/IP网络中传输SCSI指令的隧道。客户端发出的SCSI指令,由Initiator加载到TCP/IP包上进行传递,当Target接收到此数据包后,再进行协议转换,从中剥离出原始的SCSI指令,访问后端的存储体。客户端对存储的访问完全基于SCSI指令集,就像访问本地SCSI盘一样。

同时,iSCSI网络中还可以实现MPIO,即使用多于一个的物理路径访问一个存储设备,通过容错或I/O流量负载均衡的方式提供更高的系统可靠性和可用性。在保护关键业务数据的存储管理方面,使用MPIO连接iSCSI可以提供给客户额外的支持,避免数据丢失和系统故障。

IP存储是基于IP网络来实现数据块级存储的方式。由运行iSCSI协议的IP网络构架起来的SAN,简称IP-SAN。IP-SAN是基于IP网络的存储解决方案。它通过一组IP存储协议(iSCSI、FCIP、iFCP等)提供了在IP网络上封装块级请求的方法,使得我们可以使用标准的TCP协议在IP网络上传输SCSI命令和块数据。用IP网络取代FC网络连接存储设备和主机,解决FC-SAN在成本、标准性、可扩展性方面的缺陷。

随着CPU+GPU+I/O板卡技术的发展,有了基于CPU+GPU+I/O板卡技术的非线性编辑制作工作站,通过节目编辑软件就可以实现硬件视频编辑卡的功能。纯软件的工作站可以实现更多的编辑制作功能,大大降低了对网络带宽稳定的要求,使得通过纯千兆以太网上进行在线的节目编辑制作和下载成为可能。

iSCSI存储设备具有低廉、开放、大容量、传输速度高、安全等诸多优点,特别适合需要在网络上存储和传输大量数据流的非线性编辑制作网和媒体资产管理系统,符合非线性编辑网络要求高带宽、存储设备需要网络化共享的要求,实现低成本、高安全和高可用性,并具有安装、后期维护简单方便等优点。

③多NAS头系统

这种系统是基于GPFS文件系统的多NAS头存储服务器,用多个安装GPFS文件系统的节点服务器通过NFS、CIFS协议共享同一个卷。客户端对数据的访问方式与访问普通的NAS一样,只不过这个NAS头的性能可以水平扩展,当一个NAS头性能不足以满足整个系统的需要时,可以通过增加一个节点的方式扩充系统带宽。如果系统中使用其他软件代替GPFS实现多台主机以本地磁盘的形式对SAN共享存储体的访问,也可以用相同的架构构建出多NAS头的存储系统。

(3)基于私有协议的分布式存储系统

典型的分布式存储系统是Avid的ISIS和Omneon的Mediagrid,它们共同的特点是整个存储体由多个具有运算处理和存储能力的节点组成,数据根据一定的调度机制平均分散到多个节点上,并在其他节点上创建数据副本实现冗余。客户端对存储的访问都需要安装一个驱动程序,通过私有协议基于千兆以太网完成。这种存储结构的优势是多个节点并行工作,可以水平线性扩展性能,管理维护比较简单,缺点是采用的技术不开放,数据冗余至少1∶1。

Avid Unity ISIS系统采用高度可扩展的、自我平衡的分布式结构,不同于普通存储局域网,采取让智能存储元素可以做出用以集中优化整个系统的性能、容量以及健康的即时决策方式来分发数据与元数据,各个部件均采用补充式冗余配置。

(4)采用融合技术的制作网络架构

FC+以太网的双网结构在广播电视视音频系统中得到广泛应用,特别是高清电视节目制作对网络带宽的要求比标清电视高出几倍,要制作无压缩高清电视节目需要每秒一百多MB的数据量,只有4Gb FC能够满足。

电视节目制播网络采用融合式网络结构,各业务板块内容根据需要采用单网或双网结构,但各板块与主干平台的互联以单网结构为主,采用“万兆核心、千兆接入”的设计思想,各业务板块通过万兆链路连接到网络核心交换机,并针对不同的业务板块采取不同的网络安全设计和管理措施。随着IP存储技术的发展,以xSCSI可扩展智能集群存储构架为核心,采用光纤存储体加以太网络的网络架构。将双网结构的高性能与单网结构的低成本特性完美结合,具有高性价比、高安全性和高可拓展性的特点。

xSCSI架构具有高性价比、高可扩展性、高安全性等优势,IP技术和FC技术得到了最充分的融合,通过应用多种存储访问技术满足了不同站点的要求,大大提高了系统的整体性价比。

2.存储技术

在网络化制播系统中,FC-SAN、IP-SAN、NAS等不同网络架构,使用的存储技术也不同。

(1)硬盘存储

主要由FC存储技术、IP存储技术、虚拟存储技术。

①FC存储技术

由一对互为备份的阵列控制器和多个磁盘扩展柜组成,每个控制器提供4个或多个主机通道或多个磁盘通道、每个扩展柜分别连接到控制器A和控制器B的一对磁盘通道中。在每个控制器内部,包含数据读写Cache,并负责完成RAID校验的计算处理。

磁盘阵列后端磁盘通道的速度和数量是决定其带宽性能的重要因素,特别是对视音频编辑这种大数据量的应用来说,Cache的大小对性能影响不大,所有数据基本上都会占用后端磁盘通道的资源,因此磁盘通道性能通常会成为制约阵列整体性能的瓶颈所在。

主机通道与磁盘通道完全分开,即由CHA(CHIP)板负责与前端主机的连接,而由ACP板负责RAID运算和与后端磁盘的连接,每个端口为一条相对独立的磁盘通道。CHA板与ACP板都必须成对使用,CHA板与ACP板之间使用大容量Cache,并形成Crossbar的全网状线速交换,这与普通中端阵列中每个控制器中同时包括主机通道、磁盘通道和Cache的做法有很大区别。

由一对互为备份的阵列控制器和多个磁盘扩展柜组成,每个控制器提供4条主机通道、10条磁盘通道。可以看出,这种磁盘阵列最大特点在于磁盘通道数量多,而且将校验数据通道与有效数据独立传输。

②IP存储技术

主要有网关式、分布式两种,如表9-1所示。

表9-1 网关式与分布式存储

网关式有两种实现方式,一种使用标准协议(共有协议),另一种使用私有协议,二者的区别在于以太网客户端是否需要安装驱动程序,如表9-2所示。

表9-2 网关式存储实现方式

分布式也有两种,二者的区别也在于客户端是否需要安装驱动程序,如表9-3所示。

表9-3 分布式存储方式

③虚拟存储技术

随着技术的发展,虚拟存储(Storage Virtualization)技术开始融合到存储系统结构的各个环节中。虚拟存储是指将多个不同类型、独立存在的物理存储体,通过软、硬件技术,集成转化为一个逻辑上的虚拟的存储单元,集中管理供用户统一使用。这个虚拟逻辑存储单元的存储容量是它所集中管理的各物理存储体的存储量的总和,而它具有的访问带宽则在一定程度上接近各个物理存储体的访问带宽之和。从系统的观点上看,有三种主要的虚拟存储实现方式:基于服务器的虚拟存储、基于存储设备的虚拟存储以及基于存储网络的虚拟存储。(https://www.xing528.com)

基于服务器的虚拟存储是通过将虚拟化层放在服务器上实现的。这种方式不需要额外的特殊硬件,虚拟化层以软件模块形式嵌入到服务器的操作系统中,将虚拟化层作为扩展驱动模块,为连接服务器的各种存储设备提供必要的控制功能。

基于存储设备的虚拟存储是通过将虚拟化层放在存储设备的适配器、控制器上实现的。这种方式能够充分考虑存储设备的物理特性,方法简单,也为用户和系统管理员提供了最大的方便性。典型的虚拟存储就是RAID技术,RAID的虚拟化由RAID控制器实现,它将多个物理磁盘按不同的分块级别组织在一起,通过CPU及阵列管理固件来控制及管理硬盘,解释用户I/O指令,并将它们发给物理磁盘执行,从而屏蔽了具体的物理磁盘,为用户提供了一个统一的具有容错能力的逻辑虚拟磁盘,这样用户对RAID的存储操作就像对普通磁盘一样。

基于网络的虚拟存储有两种:对称式与非对称式。

对称式虚拟存储是指将进行虚拟存储管理和控制的高速存储控制设备置于网络系统的传输通道上。高速存储控制设备与存储池子系统(Storage Pool)集成在一起,组成存储区域网络应用系统(SAN Appliance)。

这里的高速存储设备在服务器与存储池数据交换的过程中起到核心作用,其虚拟存储过程是:由高速存储控制设备内嵌的存储管理系统将存储池中的物理硬盘虚拟为逻辑存储单元(LUN),并进行端口映射(就是指定某一个LUN能被哪些端口所见),在服务器端,将各个可见的逻辑存储单元映射为操作系统可以识别的盘符。当服务器向存储网络系统中写入数据时,用户只需要将数据写入到指定为自己所用的映射盘符(LUN),数据经过HSTD的高速并行端口,先写入高速缓存,高速存储控制设备中的存储管理系统自动完成目标位置由LUN到物理磁盘的转换,在此过程中用户见到的只是虚拟逻辑单元,而不必关心每个LUN的具体物理组织结构。

非对称式虚拟存储是在服务器与存储设备之间正常的数据访问传输通道之外,通过配置一个虚拟存储管理器来实现存储池的虚拟化处理。

虚拟存储管理器通过FC端口连接到存储网络中,并提供一个中央管理点,对整个存储网络进行集中管理,同时,还对磁盘阵列进行虚拟化操作,将各阵列中的LUN虚拟为逻辑带区集(Strip),指定每台服务器对每一个Strip的访问权限(可写、可读、禁止访问等)。服务器访问Strip时,先通过控制路径向虚拟存储管理器的代理发出访问Strip的请求,代理根据请求的合法性,为服务器建立访问Strip的数据通道,进行规定的读或写操作。

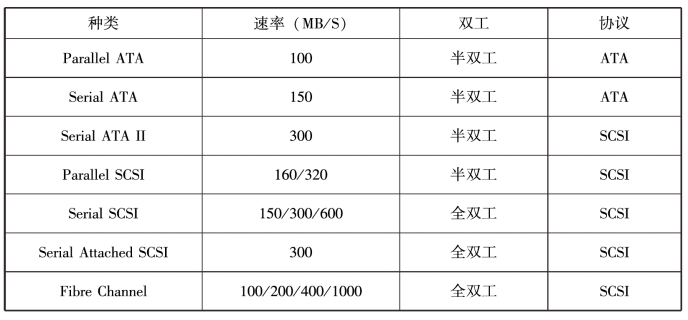

(2)磁盘接口技术

主要有以下几种磁盘接口技术,如表9-4所示。

表9-4 磁盘接口技术

(3)磁盘高可用技术

主要有磁盘RAID(Redundant Array of Inexpensive Disks,简称磁盘阵列)技术、双控制器技术。

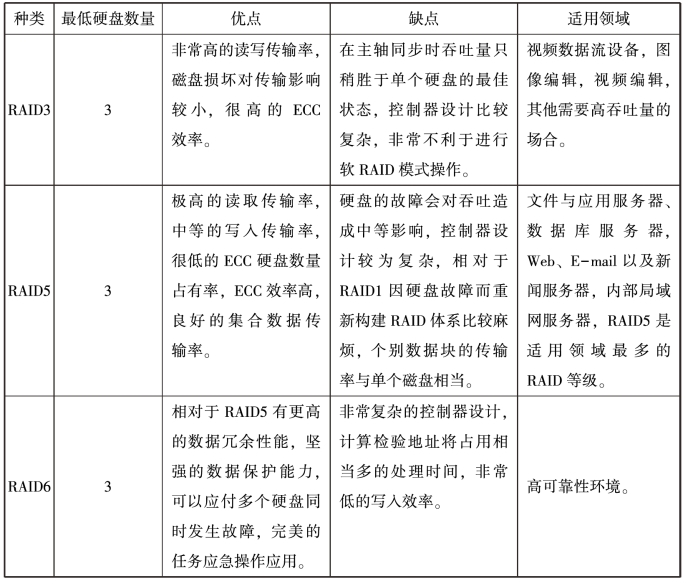

RAID技术采用若干硬磁盘驱动器按照一定要求组成一个整体,整个硬磁盘阵列由阵列控制器管理。RAID主要有RAID0、RAID1、RAID3、RAID5、RAID6,各自特点如表9-5所示。

表9-5 RAID技术特点

续表

RAID0在存储数据时由RAID控制器(硬件或软件)分割成大小相同的数据条,同时写入阵列中的磁盘。

RAID1也被称为镜像,因为一个磁盘中的数据被完全复制到另一个磁盘中,如果一个磁盘的数据发生错误,或者硬盘出现了坏道,那么另一个硬盘可以补救回磁盘故障而造成的数据损失和系统中断。

每次写数据时必须同时写入镜像盘,读数据时只从工作盘读出,一旦工作盘发生故障立即自动转入镜像盘,从镜像盘读出数据,不会造成用户工作中断,更换故障盘后,数据可以重构,恢复工作盘正确数据。

RAID3即带有专用奇偶位(Parity)的条带。每个条带片上都有相当于一“块”那么大的空间用来存储冗余信息,即奇偶位。奇偶位是编码信息,如果某个磁盘数据有误,或者磁盘发生故障,就可以用来恢复数据。

RAID3采用分条技术将数据分块,并按块分散记录在各个硬盘的相同扇区中,同时对存储的数据进行异或运算,判断其奇偶性,产生校验数据并写入最后一个硬盘中。

RAID5也被叫作带分布式奇偶位的条带,每个条带片上也都有相当于一“块”那么大的空间用来存储奇偶位。

RAID6是在RAID5基础上,为了加强数据保护而设计,实际上是一种扩展的RAID5。与RAID5不同,除了每个硬盘都有同级数据XOR校验区外,还有一个针对每个数据块的XOR校验区。

双控制器技术主要用于光纤磁盘。

多控制器的高端磁盘阵列分三层:通道控制器、全局缓存控制器、磁盘控制器。

在实际应用时,每层控制器至少成对配置,提供全冗余特性,实现无单点故障。也可以配置多对,多级控制器分工协作,使性能成倍扩展。

(4)其他存储技术

硬盘存储较多地用于在线存储,在近线存储和离线存储中常用数据流磁带。通常,磁带库按照容量大小分成三个级别:初级、中级、高级。其中,初级容量为几百GB至几TB,中级容量为几TB至几十TB,高级容量为几十TB至几百TB甚至更高。

3.数据库与服务器

网络制播系统中有各种服务器,不同服务器在各环节中发挥重要的作用,其中最重要的是数据库服务器和MDC服务器,前者是大脑,后者是心脏。

(1)数据库服务器

数据库,顾名思义是存储大数据的仓库,只是这个仓库在计算机存储设备中、数据按一定格式存储。数据库的定义是指长期存储在计算机内的、有组织的、可共享的数据集合。在网络制播系统中,数据库服务器承担着集中的统一的数据管理功能,包括制作系统、播出系统、收录系统、编目检索系统、流程及文稿管理系统等。主流数据库有:Orcale、DB2、SQL Server、Sybase。

(2)MDC服务器

MDC(Metadata Controller)是指元数据控制器,MDC服务器是光纤网中设备访问光纤(FC)磁盘阵列文件的最重要的核心服务器,如果发生故障会使网络中的各功能工作站无法访问FC盘阵内的共享资源。各工作站向FC盘阵存取素材、发送控制信息时,先由MDC设置盘阵的分区信息,通过MDC访问FC盘阵。FC盘阵内的磁盘驱动器是物理硬盘,在盘阵中将物理硬盘组合一个逻辑盘,就像一个本地的大硬盘。RAID就是在逻辑盘基础上设定的,逻辑盘可以像普通盘一样分区,每个分区可以定义一个逻辑单元(LUN)号,LUN号一般从0开始。

MDC在网络制播的共享的SAN环境中有非常重要的作用,因为所有有卡工作站都是通过MDC映射获得对共享硬盘阵列中数据的高速访问,MDC用来协调共享硬盘阵列中数据的统一性,一旦MDC出现故障,所有有卡工作站都会中断该MDC管理的卷的访问,MDC服务器主要通过安装在其上的网络存储共享管理软件对光纤磁盘阵列文件进行管理。

4.服务器群集技术

服务器群集技术是指一组相互独立的服务器在网络中表现为单一的系统,并以单一的系统模式加以管理。此单一的系统为客户工作站提供高可靠性的服务,大多数模式下,群集中所有的计算机都有一个共同的名称,群集内任一系统上运行的任务可被所有的网络用户所使用。Cluster必须可以协调管理各分离的组件的错误和失败,并可透明地向Cluster加入组件。一个Cluster包含多台(至少两台)拥有共享数据存储空间的服务器,任何一台服务器运行一个应用时,数据被存储在共享的数据空间内,每台服务器的操作系统和应用程序文件存储在其各自的本地存储空间中。Cluster各节点服务器通过一内部局域网相互通讯,当一台节点服务器发生故障时,这台服务器上所运行的应用程序将在另一节点服务器上被自动接管,当一个应用服务出现故障时,应用服务将被重新启动或被另一台服务器接管。当以上任一故障发生时,客户将能很快连接到新的应用服务上。

服务器群集技术为网络制播系统中的关键系统,如数据库、MDC以及中间件、Web服务器等提供了一个高可用、稳定安全的运行平台,使网络制播系统的性能得到提升。

服务器群集技术包括镜像技术、应用程序错误接管技术、容错技术、并行运行和分布式处理技术、可连续升级技术。

服务器镜像技术是将建立在同一个局域网的两台服务器的硬盘通过软件或其他特殊的网络设备(如镜像卡)做成镜像的技术。其中,一台服务器为主服务器,另一台为从服务器。客户只能对主服务器的镜像的卷进行读写,即只有主服务器通过网络向用户提供服务,从服务器相应的卷被锁定以防对数据进行存取。主/从服务器分别通过心跳监测线路互相监测对方的运行状态,当主服务器出现故障时,从服务器将在很短的时间内接管主服务器的应用。应用程序错误接管群集技术是将建立在同一个网络里的两台或多台服务器通过群集技术连接起来,群集节点中的每台服务器各自运行不同的应用,具有自己的广播地址,为前端用户提供服务,同时每台服务器又监测其他服务器的运行状态,为指定服务器提供热备份。当某一节点出现故障时,群集系统中指定的服务器会在很短的时间内接管故障机的数据和应用,继续为前端用户提供服务。此技术通常需要共享外部存储设备——磁盘阵列柜,两台或多台服务器通过SCSI电缆或光纤与磁盘阵列柜相连,数据都存储在磁盘阵列柜中。这种群集系统中通常是两个节点互为备份,而不是几台服务器同时为一台服务器备份,群集系统的节点通过串口、共享磁盘分区或内部网络互相监测对方的心跳。这种技术通常用在数据库服务器、MAIL服务器等群集中,最多可以实现32台服务器群集。

容错群集技术的典型应用是容错机,在容错机中每一个部件都有冗余设计。容错群集技术中群集系统的每一个节点都与其他节点紧密相连,经常需要共享内存、硬盘、CPU、I/O等重要的子系统,各个节点被共同映射为一个独立的系统,所有节点都是这个映射系统的一部分。各种应用在不同节点之间的切换很平滑,不需切换时间。容错群集系统主要用于要求可用性很高的场合,如财政、金融、安全部门等。

并行运行和分布式处理技术与其他群集技术不同,主要用来提高系统的计算能力和处理能力。这种系统提交应用被分配到不同的节点中分别运行,如果任务比较大,系统将其分成许多小块,然后交给不同的节点处理,类似于多处理器协调工作。

可连续升级的群集技术是前几种技术的组合,可提供连续升级能力。系统中通常有一个负责管理整个群集系统的中央节点,将用户的请求分配给系统中其他某个节点,然后这个节点将直接通过Internet网络向用户提供服务。系统中每一个节点都互为备份,包括中央节点,它在完成向群集节点分配任务的同时也向用户提供服务。一旦中央节点出现故障,系统将自动推举一个节点为中央节点接管全部应用。这种系统通常只需简单的设置就可以添加或删除一个节点,使用管理比较简单,通常用于Web、MAIL、FTP等服务。

5.压缩编码技术

对于“非编”来说,压缩方式的选择首先要考虑视频质量问题,其次是提高压缩效率、兼容性、开放性、格式间转换损失等问题。

视频压缩格式很多,在制播网络中常见的格式有MPEG-2I帧、MPEG-2 IBP、MPEG-4、DVCPRO50、DVCPRO、DV、JPEG、WMV、H.264、AVS等。

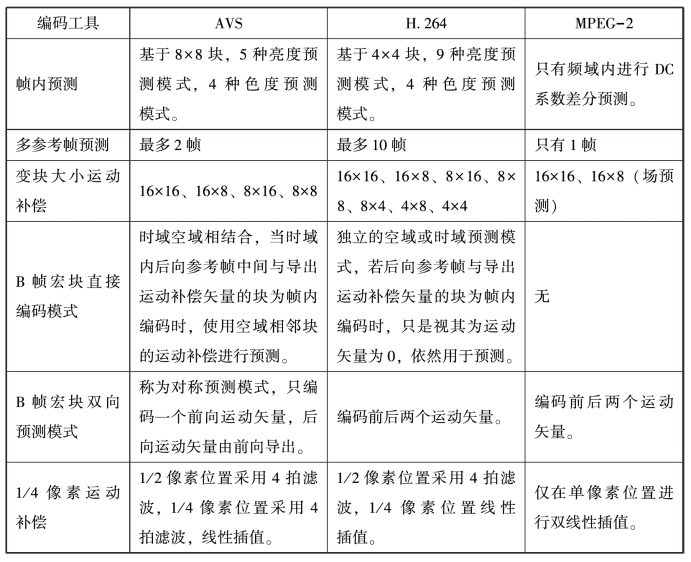

AVS是我国具有自主知识产权的第二代信源编码标准,“信源”就是信息的源头,信源编码技术解决的重点问题是数字音视频海量数据的编码压缩问题,称之为数字音视频编解码技术。编码压缩和解码技术是数字信息传输、存储、播放等环节的前提,因此信源编码标准是数字音视频产业的共性基础标准。

信源编码标准有四个:MPEG-2、MPEG-4、MPEG-4AVC(简称AVC,也称JVT、H.264)、AVS。从制定者分,前三个标准是由MPEG专家组完成的,第四个是我国自主制定的。从发展阶段分,MPEG-2是第一代标准,其余三个为第二代标准。从主要技术指标——编码效率比较:MPEG-4是MPEG-2的1.4倍,AVS与AVC相当,都是MPEG-2两倍以上。

AVS标准是《信息技术先进音视频编码》系列标准的简称,AVS包括系统、视频、音频、数字版权管理四个主要技术标准和一致性测试等支撑标准。

AVS标准的核心技术包括8×8整数变换与量化、帧内预测、1/4精度像素插值、特殊的帧间预测、运动补偿、二维熵编码、去块效应环内滤波等。

主要技术比对,如表9-6所示。

表9-6 几种信源压缩编码标准主要技术比对

续表

6.非线性编辑技术

非编系统不同于普通的计算机,关键在于视频处理硬件板卡,一般包括I/O卡、编解码及图像处理卡、强化特效的实时三维特技卡,其他软硬件都是对非编板卡功能的辅助与增强。对板卡的要求有图像/声音质量、图像处理复杂性(实时层数和特效)、系统开放性及兼容性(多种编解码格式及第三方插件)。

非编系统经历了三代:第一代基于M-JPEG编码,是延续传统的板卡型;第二代压缩格式从M-JPEG到MPEG-2;第三代是借助计算机及硬件加速的软件型。

非编系统的发展方向是实现更多的软件处理,理想的非编系统是各部分功能模块化、支持多层实时回放、具备开放性、具备良好的扩展性、成本合理、支持全程非线性制作。

7.安全技术

安全是广播电视的根本要求,在数字化、网络化时代,更需要构建一个安全、高可用的系统。

可用性表明一个系统提供服务的能力。

可用性={MTBF/(MTBF+MTTR)}×100%

总运行时间由两部分组成:一部分是正常运行时间,另一部分是修复时间。MTBF是两次故障间隔时间,也就是安全运行的时间,MTBF描述了系统安全可靠运行、能够正常提供服务的时间。MTTR是系统故障修复的时间,修复期间不能提供服务,修复时间越短越好。系统故障间隔时间越长、修复时间越短,系统的可用性越高。

可用性有三种表示方法:一是用百分比表示,如上述表达式;二是用几个9表示,如99%、99.99%等,通称两个9、四个9等,其含义是指百分之一、万分之一的修复时间等;三是用“年停机时间”表示,如每年停机50分钟或5分钟,相当于四个9、五个9的水平。对不同的应用可有不同的可用性要求,关键性业务如通信需要五个9或六个9,即一年内停机时间在5分钟至0.5分钟的水平,而一般性业务如桌面计算机只有三个9也能满足应用,偶尔停一下也可以接受,广播电视播出也是五个9或六个9,否则不能满足安全播出的要求。一个系统不可能不停机,但停机就会中断服务。停机可划分为两类:计划停机和非计划停机。计划停机是人为安排的停机,如检修,包括软件升级、打补丁、硬件升级等;非计划停机是系统内外故障,如软硬件故障、停电、断网等。两类停机的区别在于:计划停机是可控的,后果也是可预测的,而非计划停机是不可控的,发生时间和影响范围都是不可预测的。

网络制播系统的安全运行必须做好设计、运维和管理,三者缺一不可。设计目标要根据安全等级提供相应的冗余和切换能力;运维目标是监测运行参数、优化运行环境、维持系统健康、消除安全隐患;管理目标是通过建章立制、规范操作保证系统正确、合理使用。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。