实验部分采用TDT评测会议给出的测试集合和评价标准验证本章提出的话题字典生成算法的有效性,实验内容包括四项:①上下文信息中参数N的确定;②运用坐标下降法获得测试集合中每个话题的初始有判别力的词;③运用一个双层循环算法获得相似度阈值λ;④采用基于信念网络的话题模型作为表示模型,验证ISD和BSD算法的时间消耗,以及BSD与ITF-IDF话题字典生成方法对系统追踪性能的影响。

1.上下文关系中N的确定

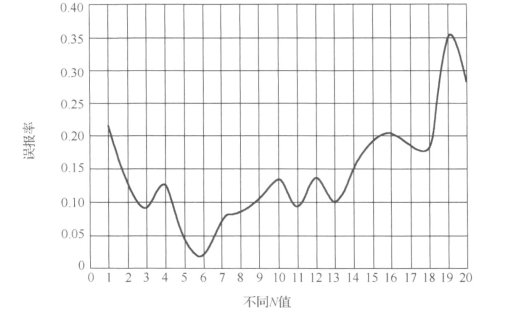

在话题字典生成的过程中,本章给出的目标函数除了考虑直接获得的有判别力词wl外,还考虑和其有上下文关系的N个近邻词。理论上,合适的N值是可以降低话题识别与追踪的误报率,但是如果N值过大,则会产生冗余信息,提高误报率。该项实验以信念网络话题模型作为表示模型,对32个标注的中文话题分别计算当1≤N≤20时,话题追踪的误报率值,然后求均值,获得图4-4所示的实验结果,实验中的相似度阈值λ采用获得的阈值0.47。从图4-4中可以看到,当N=6时,误报率值为0.0214,其值最低,故在后续实验中我们将考虑和当前有判别力词有上下文关系的6个近邻词。

图4-4 不同N值对应的误报率

2.初始话题字典的生成

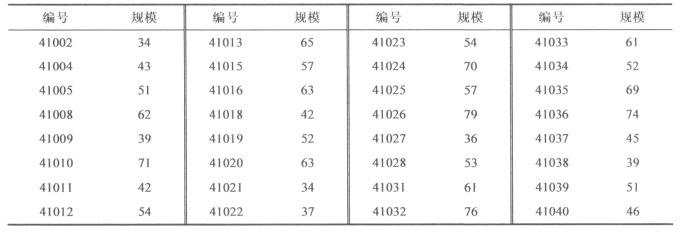

式(4-18)给出了求解L个话题初始字典规模的目标函数,该函数可采用上述的坐标下降法求解,TDT语料中可用的话题数量L取值为32。在上述算法中预设参数φ的值为0.01,当外循环执行到第12次时,满足![]() ,获得TDT语料中已经标注的32个中文话题的初始话题字典规模,如表4-6所示。知道了规模的大小,很容易建立话题的初始字典,例如,表中41022话题的规模为37,则将41002话题中的所有特征互信息值降序排序,取互信息值较大的前37个特征表示该话题即可。

,获得TDT语料中已经标注的32个中文话题的初始话题字典规模,如表4-6所示。知道了规模的大小,很容易建立话题的初始字典,例如,表中41022话题的规模为37,则将41002话题中的所有特征互信息值降序排序,取互信息值较大的前37个特征表示该话题即可。

随着话题的不断发展,新的新闻报道将加入到初始话题,而且话题的数量也会增加,在话题识别与追踪的过程中,我们将运用文章提出的BSD算法反复使用上述的坐标下降法不断更新话题字典,以提高话题识别与追踪系统的综合性能。

表4-6 初始话题字典规模

3.阈值λ的获得

阈值λ为相似度阈值,如果其值过高,则会降低误报率,同时漏报率也会增加;如果值过低则会提高误报率。针对测试集合中已经标注的32个中文话题,我们采用如下算法获得λ的较优值。

输入:阈值λ的范围为[0,1],增长幅度为r;

输出:λ的较优取值;(https://www.xing528.com)

Step 1.外循环:forλi=0.01 to 1.0,λi+1=λi+0.01;

Step 2.内循环:forj=1 to 32;

Step 3.计算阈值为λi时,32个中文话题的平均错误识别代价Averageλi((Cdet)norm);

Step 4.forλi=0.01 to 1.0,λi+1=λi+0.01,获得Min(Averageλi((Cdet)norm)),此时的λi即为λ的较优取值。

实验运行结果显示相似度阈值λ的较优取值为0.47。如果想获得更为精确的阈值,可调整增长幅度r的值。

4.性能比较

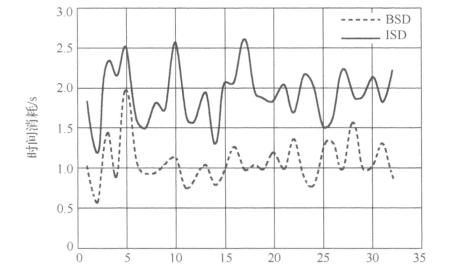

本章提出了两个话题字典生成算法:增量式报道字典(ISD)和批量式报道字典(BSD)。在ISD算法中,报道的大量出现必然导致话题字典中有判别力词的更新频率过高,致使算法效率下降。为了提高算法效率,提出了批量话题字典生成算法BSD,该算法不是来一个报道处理一次,而是批量处理,所以从理论上,其时间消耗应低于ISD算法。该项实验首先验证ISD和BSD算法中字典生成的时间消耗,然后以信念网络话题模型作为表示模型,比较ISD、BSD和增量式TF-IDF方法的追踪性能。

TDT4中文测试集合已经给出了每个中文话题相关和不相关的新闻报道,我们首先将这些报道按照时间顺序排序,然后分别采用ISD算法和BSD算法计算每个话题字典(32个已经标注的中文话题)生成的时间消耗,最后求平均,比较二者的时间消耗均值。其中,在BSD算法中我们批量处理的R值暂定为20,图4-5为实验结果,从图中可以看出BSD算法的时间消耗均值明显低于ISD算法,即BSD算法的效率较高。

图4-5 ISD和BSD时间消耗比较

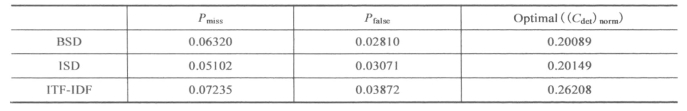

以BDTM-Ⅱ作为表示模型,计算三种话题字典生成算法在12个不同阈值下的Pmiss和Pfa,并运用公式计算12个阈值下的(Cdet)norm,其中最小的(Cdet)norm即为optimal((Cdet)norm),结果如表4-7所示。依据TDT评测会议给出的评测标准,(Cdet)norm值越小,性能越好,从表4-7可以看出BSD算法的最优性能较好,虽然BSD算法最优性能值略低于ISD算法,但是其间消耗明显低于ISD算法。

表4-7 BSD和ISD算法最优性能比较

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。