通常信道模型的建立方法分为实际测量和理论分析,其中实际测量代价大、周期长、实现复杂、普适性差,而从理论分析上构建传播模型则花费小、灵活性高。目前,从实际测量和理论分析方面,已经提出了多种室内红外光通信系统信道模型。但是,可见光通信系统信道模型的建立尚处于探索阶段,还没有被学术界所广泛认可的信道模型[4]。由于可见光和红外光的波长相近,因此关于可见光通信的研究主要还是利用室内红外光通信的信道模型。

2.4.1 相关研究

光信号在室内无线信道传输时,信道所造成的光功率损耗主要由两个因素造成,即光路径损耗和多径色散。对于LOS传播,路径损耗与光束发散度、检测器尺寸和收发端之间距离有关,不需要考虑反射信号的影响。而对于室内漫射系统,多径色散将进一步造成路径损耗。

目前,国内外学者提出了多种室内漫射光无线信道建模的方法。文献[5]采用950nm的红外光源,设计了一种室内漫射无线广播系统,从理论上分析了时间弥散和背景噪声对传输速率的影响,研究了光漫射信道的信道模型,并建立了基于脉冲编码调制(PCM)的试验系统。文献[6]在任意房间中,考虑朗伯(Lambertian)反射,提出了一种迭代法计算自由空间光信道冲激响应的方法,该方法可以计算多次反射,并能够准确分析多径对光无线通信系统的影响。文献[7]考虑漫射红外光无线信道,通过估计时延扩展均方根(RMS spread delay)和平均超量时延(mean excess delay)参数,建立了一种计算复杂度低、使用灵活,结果和迭代法近似的统计信道模型。文献[8]提出了一种复杂度较低的信道建模方法,该方法不是按照房间内墙面反射单元的反射次数进行的,而是按照光在反射单元之间传输需要的时间,用矩阵存储反射单元之间的功率贡献,最后计算每一个单元的接收功率。文献[9]用直流增益表示红外信道的频率响应,给出了视线传播、定向无LOS和漫射无LOS时的信道直流增益计算方法。文献[10]考虑室内墙面反射时的漫射无线信道,随机产生信源光信号,用蒙特卡洛仿真方法计算信道冲激响应,该方法中信源和反射单元可以服从Lambertian反射,也可以服从其他非Lambertian反射。由于基带调制(OOK,PPM)的发射功率和光信号的延迟扩展均方根(RMS)相关,IM/DD系统漫射信道可以由路径损耗和延迟扩展因子描述,文献[11]提出了Ceiling-bounce信道模型。文献[12]在蒙特卡洛算法的基础上提出了光线追迹法,通过计算每一条射线经过多次反射对信道冲激响应的贡献来计算信道脉冲响应。文献[13]给出了LOS信道和反射信道直流增益的计算方法,在接收端将延时大于系统发射符号周期的所有光信号都看作符号间干扰(ISI)信号,小于符号周期的光信号作为有用的信号,将符号间干扰信号看作高斯噪声,分析了SNR在室内的分布情况。

北京邮电大学的丁鹏举提出了独立反映元素交互表征建模方法,该方法不仅可以计算信道冲激响应,而且还可以计算亮度分布特性[4]。华中科技大学的谭家杰采用光线追迹法计算信道冲激响应,在室内MIMO系统中仿真了各次反射的信道冲激响应以及频率响应[14]。华东理工大学的喻晓、樊凌涛对室内VLC-MIMO系统中每一对LED和PD之间的时域冲激响应进行了分析[15]。

2.4.2 LOS信道冲激响应

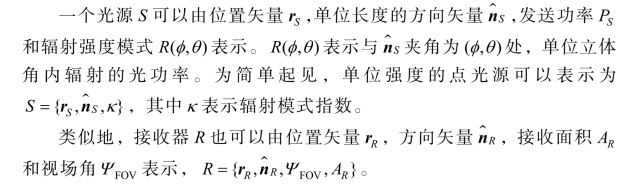

LOS链路的几何传输模型如图2.5所示,一般情况下在室内可见光通信系统会选用具有较大发射角的LED,接收端PD的检测面积也较大。

图2.5 LOS信道传输模型

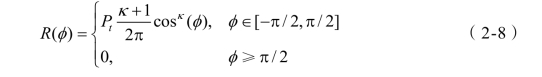

朗伯辐射模型LED的辐射强度分布表示为

式中,φ是光信号的出射角,φ=0代表光源最大辐射功率,κ是表征光源辐射方向性的辐射模式指数,和LED的半功率角Φ1/2相关,定义为

![]()

表面积为 AR的光电检测器能够检测到入射角小于视场角的入射光信号,PD的有效检测面积为

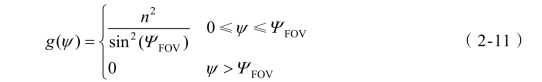

式中,ψ表示光信号入射到PD的入射角。虽然,室内可见光通信要尽可能地选择检测面积大的PD,这样可以接收到更多的光强信号,但这实际上会带来诸多问题。比如,会增加成本、增加结电容,从而减小接收带宽和增加接收噪声。因此,采用非成像接收的集中器可以增加PD的有效面积,折射率为n的集中器的增益为

式中,ΨFOV表示FOV角。

室内光无线链路相对较短,因此可以忽略大气的吸收和散射对光信号的衰减。假设接收端采用了带通滤光器,且增益为 T(ψ),那么距离为d,出射角为φ的LOS信道直流增益为

在短距离LOS链路中几乎可以不考虑多径传输,LOS链路认为是非频率选择性信道,信道建模为一个线性的衰减和延迟,冲激响应为

2.4.3 漫射信道冲激响应

对于非定向LOS和漫射链路,由于受到房间大小、室内物体的反射系数、收发端的位置和方向,以及窗户位置等因素的影响,光路径损耗的计算非常复杂。理论上来说,积分所有到达接收端的经过多次反射的光信号功率可以获得光无线信道的冲激响应[16]。

虽然通过光功率在室内的分布情况可以确定系统的功率预算,但由于没有考虑反射,因此它不能够解释由于多径传播而导致的功率代价(power penalty)。通常,接收信号总功率中包含的经过二次反射和更多次反射信号的功率贡献相对很小,但多次反射信号的延迟比LOS和一次反射信号大很多,因此,当在高速的非定向LOS和漫射链路中不能忽略其影响。

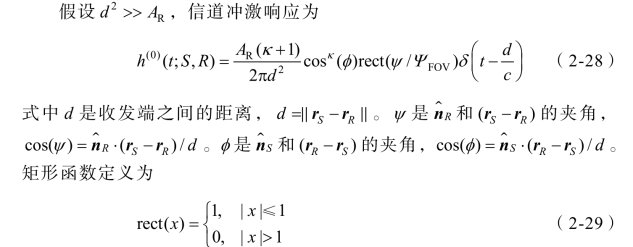

假设室内分布有一对光源S和接收器R,那么冲激响应为

以下介绍几种常用的光无线通信漫射信道模型。

1.Gfeller模型

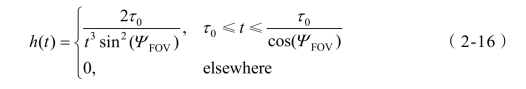

文献[5]考虑多径传播对信号的影响,将反射平面划分为小反射单元,并假设满足Lambertian反射提出了Gfeller模型,归一化的信道冲激响应为

式中,τ0是信源到收端的光信号最小延迟。图2.6所示为Gfeller模型冲激响应 h(t)的变化图,可以看出,当PD的FOV减少时,经过房间和家具反射的信号中能进入到PD的光信号减少,因而冲激响应的宽度变小。当FOV角变大时,进入PD的反射信号和功率都增大,延迟扩展也变大,将导致更严重的符号间干扰,降低系统性能。

图2.6 Gfeller传输模型

2.Ceiling-Bounce模型

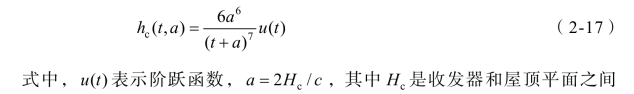

Ceiling-Bounce信道模型具有简单的闭合表达式,经验证与实验数据高度吻合,故得到了广泛的应用。该模型假设有一个无限大的反射平面,这就近似一个面积很大的房间,发射器和接收器都处于房间的中心附近,并和地面平行的平面上,此时只考虑一次反射光线,可以忽略从墙壁和屋顶的高次反射信号。描述多径信道只用到两个参数,即光路径损耗和信道均方根延迟扩展Drms,信道冲激响应表示为

Ceiling-Bounce信道模型的3dB截止带宽近似为(https://www.xing528.com)

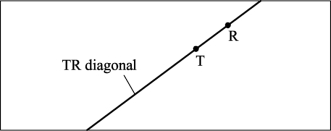

对于一个实际的信道,收发器不一定在房间中心附近,它们之间的距离可能较远,反射平面通常不是无限大,因此经过墙壁的反射信号增大,延迟扩展Drms也增大,需要对信道模型修正。用 h1(t)表示房间屋顶是一个无限大反射平面,不考虑墙壁反射时的冲激响应。如图2.7所示,s定义为收发器(TR)之间的水平距离和TR斜线之比,TR斜线为TR的延长线段在室内的长度。

图2.7 Ceiling-Bounce信道模型修正参数示意图

对于无遮挡信道,可以用s的二次方程预测多次反射引起的延迟扩展,修正a表示为

![]()

对于有遮挡信道,延迟扩展更容易变化,但仍然随着TR之间的距离增大而增大,修正a表示为

![]()

修正变量s只和收发器之间的水平距离有关,没有考虑垂直方向上的高度差。文献[7]用统计模型估计延迟扩展因子,表示为

![]()

式中,derr表示发射器—反射点—接收器之间的距离,κ是发射器Lambertian辐射指数。文献[17]将Drms统计模型和Ceiling-Bounce模型结合,提出了一种修正的Ceiling-Bounce信道模型。

3.Sphere模型

文献[18]接收端可以收到LOS和漫射信号,信道的冲激响应表示为两路独立的并联响应之和,其中LOS信道可用Dirac函数建模,漫射信道采用积分球(integration-sphere)模型,

![]()

式中ηLOS是LOS信道增益,ΔT代表收到漫射信号的起始时间相对于LOS信号的延迟。

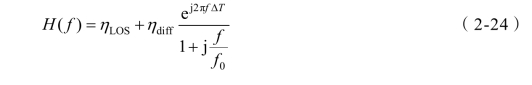

信道的频率响应为

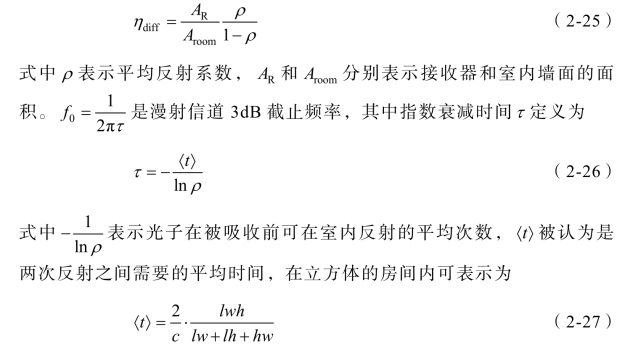

式中ηdiff表示漫射信道增益,不随接收端在室内位置的改变而变化,是一个常数,可表示为

式中l,w,h分别表示房间的长、宽和高。

4.迭代法计算冲激响应

迭代法可以计算经过任意次反射后系统的冲激响应,分析信号的时域扩展对系统的影响[6]。

1)光源和接收器模型

2)反射模型

虽然光信号的反射包括镜面反射和漫反射,但经实验验证,典型的室内墙面和家具的反射可以用Lambertian辐射模型,墙面反射单元的辐射强度模式 R(φ)与入射光的入射角无关。因此,可将一个面积为dA、反射率为ρ的微反射单元上的反射分解为两步:第一步,将微反射单元看作面积为dA,功率为dP的接收器;第二步,把这个微反射单元当作功率为P=ρdP,辐射强度指数κ=1的Lambertian光源。

3)LOS信道冲激响应

4)反射信道冲激响应

对于光源S和接收器R,接收端可以收到经过多次反射后的光信号,冲激响应表示为

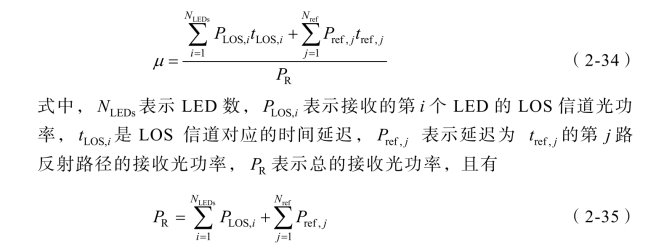

2.4.4 信道延迟扩展

在漫射系统中,光信号经过不同路径到达接收端,因此接收光脉冲被展宽。光路径的长度通常和房间的大小有关,可以用均方根时延扩展描述多径信道时间弥散性的大小。将反射平面划分为小反射单元后,平均延迟扩展定义为

RMS延迟扩展定义为

![]()

式中,

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。