多任务学习(multi-task learning)是机器学习的一种方法,它是指在同一时间用同一种共享的表示来学习和解决一些相关问题的方法。它可以看作是迁移学习(transfer learning)或者知识迁移学习的两大主要类别之一,研究重点是分布、领域或者任务上的泛化。另一种主要的迁移学习叫做适应性学习(adaptive learning),在这类学习中,知识迁移是以一定顺序进行的,从源任务到目标任务的迁移是其中的一个代表。多模态(multi-modal)学习与多任务学习是紧密相关的,这些学习领域或“任务”涵盖了人机交互的多个模态或者包含兼有文本、语音、触感和视觉信息资源的其他应用。

深度学习的本质是自动地发掘任意一种机器学习任务中有效的特征或表示,其中包括从一个任务到另一个任务即时的知识转移。多任务学习通常用于目标任务领域训练数据匮乏的情况,因此有时也称之为零样本(zero-shot)或单样本(one-shot)学习。很明显,复杂的多任务学习很符合深度学习或者表示学习的要求。在资源匮乏的机器学习场景中,共享的表示以及任务中(包括语音、图像、触感和文本等不同模态的任务)所使用的统计方法的力量将会体现得淋漓尽致。在使用深度学习方法之前,多模态和多任务学习已经有很多的研究工作,例如,一个叫做MiPad的多模态交互原型,该原型能够捕捉、学习、协调以及渲染语音、触觉和视觉的混合信息。利用不同传感特性的麦克风来采集骨传导以及空气传导路径的混合声源,进行语音降噪。这些早期的研究都使用浅层模型和学习策略,得到的结果也差强人意。随着深度学习的出现,复杂的多模态学习问题看到了曙光,一旦这一难题被攻克,实际应用将会如雨后春笋般层出不穷。本章中,我们精心挑选了这个领域内的一些应用进行详细的阐述,它们是按照模态间的不同组合或者不同的学习任务进行组织的。

一、多模态:文本和图像

文本和图像可以进行多模态学习的根本原因是它们在语义层面是相互联系的。我们可以通过对图像进行文本标注来建立二者之间的关系(作为文本和图像多模态学习系统的训练数据)。如果相互关联的文本和图像在同一语义空间共享同一表示,那么系统可以推广到不可见(unseen)的情况;不管是文本还是图像缺失,我们都可以用共享的表示去填补缺失的信息,因此可以自然地应用于图像或文本的零样本学习。换言之,多模态学习可以使用文本信息来帮助图像/视觉识别,反之亦然。当然,这个领域的绝大多数研究集中在通过文本信息来进行图像/视觉识别中。

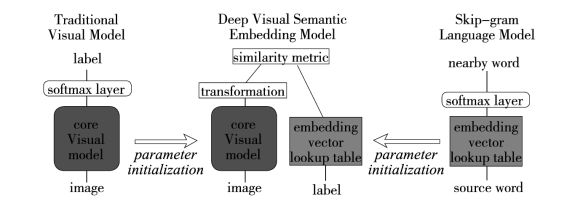

由Frome等人提出的深层体系结构DeViSE(深度视觉一语义嵌入)是利用文本信息来提高图像识别系统性能的多模态学习的典型示例,这种体系结构尤其适合零样本学习(zeroshot learning)。当物体的类别太多时,很多图像识别系统是不能正常运转的,部分原因是由于随着图像的类别个数增加,获取足量带有文本标签的训练数据也越来越难。DeViSE系统旨在利用文本数据去训练图像模型。通过带有标注的图像数据以及从没有标注的文本中学习到的语义信息来训练一个联合模型,然后利用训练好的模型对图像进行分类。图8-19中间部分是对DeViSE体系结构的一个图解。用较低层的两个模型预训练得到的参数对DeViSE进行初始化,这两个模型分别是:图中左侧部分用于图像分类的深度卷积神经网络和图中右侧部分的文本嵌入模型。图8-19中标记为“核心视觉模型”的深度卷积神经网络部分通过标记为“转换”的投影层和一个相似度度量来进一步学习如何去预测词嵌入向量。训练阶段所采用的损失函数是内积相似度以及最大边界的结合体,即铰链排名损失。内积相似度是余弦损失函数的非归一化形式,目的是为了训练DSSM模型。最大边界类似于较早的图像一文本模型WSABIE(由Weslon等人提出的运用图像嵌入进行大批量网络标注的方法)。结果表明,由文本提供的信息提高了零样本预测的准确性,使得成千上万在模型中未曾出现过的标签的命中率达到了比较好的水平(接近15%)。

图8-19 多模态DeVISE架构图解

图中词语翻译对照表

早期的WSABIE系统,它用浅层结构来训练图像和标注之间的联合嵌入向量模型。WSABIE使用简单的图像特征和线性映射实现联合嵌入向量空间,并非在DeViSE中利用深层结构来得到高度非线性的图像(文本向量也一样)特征向量。这样,每一个可能的标签都对应一个向量。因此,相比DeViSE来说,WSABIE不能泛化新的类别。

对比图8-19的DeViSE架构以及DSSM体系结构,我们会看到一些很有意思的不同点。DSSM中的“查询”和“文档”分支类似于DeViSE中的“图像”和“文本一标注”分支。为了训练端对端的网络权重,DeViSE和DSSM所采用的目标函数都是和向量间余弦距离相关的。一个关键的不同点在于DSSM的两个输入集都是文本(例如,为信息检索设计的“查询”和“文档”),因此,相比DeViSE中从一个模态(图像)到另一个模态(文本)而言,DSSM中将“查询”和“文档”映射到同一语义空间在概念上显得更加直接。而另外一个关键的区别在于DeViSE对未知图像类别的泛化能力来源于许多无监督文本资源的文本向量(即没有对应的图像),这些资源包含未知图像类别的文本标注。而DSSM对于未知单词的泛化能力来源于一种特殊的编码策略,这种策略依据单词的不同字母组合来进行编码。

最近,有一种方法受到DeViSE架构的启发,通过对文本标注和图像类别的向量进行凸组合来将图像映射到一个语义向量空间这种方法和DeViSE的主要区别在于,DeViSE用一个线性的转换层代替最后激活函数为softmax的卷积神经网络图像分类器。新的转换层进而和卷积神经网络的较低层一起训练。有方法更为简单——保留卷积神经网络softmax层而不对卷积神经网络进行训练。对于测试图像,卷积神经网络首先产生N个最佳候选项。然后,计算这N个向量在语义空间的凸组合。即得到Softmax分类器的输出到向量空间的确定性转化。这种简单的多模态学习方法在ImageNet的零样本学习任务上效果很好。

另一个不同于上述工作但又与其相关的研究主要集中在多模态嵌入向量的使用上,来源于不同模态的数据(文本和图像)被映射到同一向量空间。例如,Socher和Fei-Fei利用核典型相关性分析(kernlized canonical cor-relation)将词和图像映射到同一空间。Socher等人将图像映射到单个词向量,这样构建的多模态系统可以对没有任何个例的图像类别进行分类,类似于DeViSE中的零样本学习。Socher等人的最新工作将单个词的嵌入拓展为短语和完整句子的嵌入。这种从词到句子的拓展能力,来源于递归神经网络和对依存树的扩展。

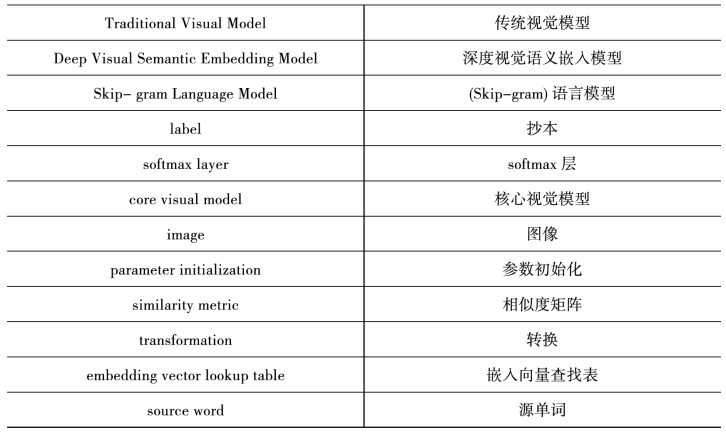

除了将文本到图像(反之亦然)映射为同一向量空间或者创建一个联合的图像/文本嵌入空间,文本和图像的多模态学习也同样适用于语言模型的框架。研究着眼于建立一种自然语言模型,这个模型依赖于其他模态,例如图像模态。这类多模态的语言模型被用于(1)对于给定的复杂描述的查询来检索图像;(2)对于给定的图像查询检索出相应的短语描迷;(3)给出图像相关文本的概率。通过训练多模态语言模型和卷积神经网络的组合来联合学习词表示和图像特征。图8-20是多模态语言模型的一个图解。

图8-20 多模态语言模型

图中词语翻译对照表

二、多模态:语音和图像

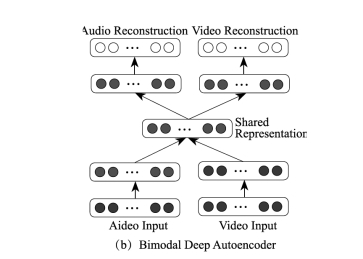

Ngiam等人提出并评估了用神经网络来学习音频/语音和图像/视频模态特征的应用。他们论述了两感交叉(cross-modality)特征学习,指出在特征学习阶段,多模态(例如,语音和图像)会比只有一个模态(例如,图像)学到更好的特征。图8-21展示了一个用来分离音频/语音和视频/图像输入通道的双模深度自编码器(bi-modal deep autoencoder)架构。这个架构的本质是利用一个共享的中间层来表示两种模态。更进一步说明了如何去学习语音和视频的共同表示,并且在一个固定的任务中去评估它,分类器用语音数据进行训练,但是测试的时候用的是视频数据,反之亦然。这项工作的结论是:深度学习的架构通常对从无标注的数据中学习多模态特征以及通过两感交叉信息传递来提高单个模态特征的情况是很有效的。但是这个方法在CUAVE数据库上出现了例外。结果表明通过视频和音频去学习视频特征的效果优于仅用视频特征。然而,这篇论文同时指出用复杂信号处理技术提取的视觉特征,外加从鲁棒语音识别中提出的非确定性补偿方法,最终得到的模型在两感交叉学习任务上可以达到最好的分类精度,超越了深度结构的效果。

图8-21 用于多模态音频/语音和视觉特征的深度除噪自编码器的体系结构

图中词语翻译对照表

用深度生成式架构来进行多模态学习的方法是基于非概率的自编码器,然而近来在相同的多模态应用中也出现了基于深度玻尔兹曼机(DBM)的概率型自编码器。一个DBM用来提取整合了不同模态的统一表示,这一表示对分类和信息检索任务来说都是很有帮助的。与为了表示多模态输入而在深度自编码器中采用的“瓶颈”层不同的是,这里我们首先在多模态输入的联合空间中定义一个概率密度,然后用定义的潜在变量的状态作为表示。DBM的概率公式在传统的深度自编码器中是没有的,因此这里概率形式的优势在于丢失的模态信息可以通过从它的条件概率中采样来弥补。最近自编码器的许多工作中表明,推广的降噪自编码器的采样能力使得填补缺失模态信息的问题看到了曙光。对于包含图像和文本的双模态数据,研究表明,多模态DBM比传统的深度多模态自编码器以及在分类和信息检索任务中的多模态DBN效果稍好。目前与推广的深度自编码器还没有比较的结果,但是相信结果可能很快就会出来。

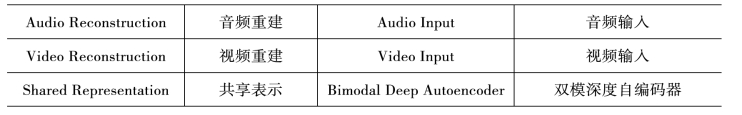

多模态处理以及学习的若干架构可以看作是多任务学习(multi-task learning)和转化学习(transler learning)含适应性和多任务学习,指的是一种学习架构或技术,可以发掘不同学习任务中隐藏的共同的解释性因素。这种方式允许不同的输入数据集进行一定的共享,因此是允许在看似不同的学习任务中进行知识传递的。图8-22的学习架构和关联的学习算法对该类任务是有优势的,这是因为它能够学习捕捉潜在因素的表示,这些因素的子集和某个特定任务相关。我们将会在本章剰余的部分讨论语音、自然语言处理或者图像领域中若干多任务学习的应用。(https://www.xing528.com)

图8-22 学习架构

图中词语翻译对照表

三、在语音、自然语言处理或者图像领域的多任务学习

在语音领域中,最有意思的多任务学习应用当属多语种或者交叉语种的语音识别,不同语言的语音识别被当作不同的任务。为了解决语音识别中非常有挑战性的声学建模问题,已经出现各种各样的方法。然而出于经济层面的考虑,构建全世界所有语种的语音识别系统,瓶颈在于缺乏标注的语音数据。对于高斯混合模型一隐马尔可夫模型(GMM-HMM)系统而言,交叉语种的数据共享以及数据加权是最普遍且行之有效的方法。GMM-HMM中另一种成功的方法是通过基于知识或者数据驱动方法来完成跨语言的发音单元映射。但是这些方法的效果是远不如深度神经网络—隐马尔可夫模型(DNN-HMM)的。

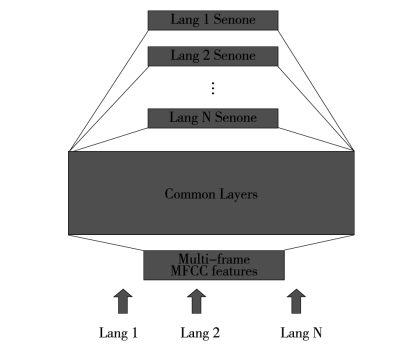

两个研究小组独立提出了非常相近的、具有多任务学习能力、用于多语种语音识别的深度神经网络架构。从图8-22中我们可以看到这种架构的图解。这一架构的思想是:通过适当的学习,深度神经网络中由低到高的隐层充当着复杂程度不断增加的特征变换,而这些变换共享跨语言声学数据中共有的隐藏因素。神经网络最后一个softmax层充当着一个对数线性(log-liner)分类器,利用了最顶端隐层所表示的最抽象的特征向量。尽管对数域的线性分类器对不同语言在必要时可以分开,但特征转换仍可以在跨语言之间共享。报告的多语种语音识别的效果非常好,这个结果比基于GMM-HMM的方法好很多。这些工作的意义是重要而深远的,它表明了我们可以从一个现有的多语种DNN中快速构建出一个性能良好的新语种DNN识别器。这样最大的好处莫过于我们只需要目标语言少量的训练数据,当然有更多的数据可以进一步地提高性能。这个多任务的学习方法可以降低无监督预训练阶段的需求,并且可以用更少的迭代次数进行训练。对这些工作进行推广,就可以高效地构建一个通用语言的语音识别系统。这样的系统不仅能够识别许多语言以及提高每种语言的识别精度,还能够通过简单地堆叠DNN的softmax层扩展到对一种新的语言的支持。

图8-22 一种用于多语种语音识别的DNN架构

图中词语翻译对照表

![]()

续 表

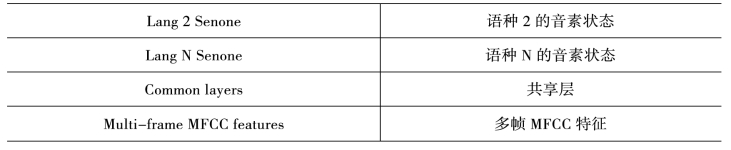

图8-23是一个与上述模型密切相关的、具有多任务学习能力的深度神经网络架构。该模型最近被应用到了另一个声学建模的任务中——学习两个不同声学数据集合的联合表示。数据集包含宽带、高质量的16kHz采样率的语音数据,这些数据通常是从日趋流行的智能手机语音搜索应用中采集到的。而另外一种,采样率是8kHz的窄带数据集通常是通过电话语音识别系统采集而来的。

图8-23 用16kHz和8kHz采样率混合带宽的声学数据训练语音识别的一个DNN架构

图中词语翻译对照表

续 表

下面介绍语音领域的最后一个多任务学习的例子。首先,我们将音素识别和词识别当作是两个单独的“任务”。音素识别的结果往往被用于口语文本检索中语种类型的鉴别,而不是用于产生文本输出。音素识别的结果不是用来产生文本输出,而是用来做语种辨识或者语音文档检索。进而,在几乎所有语音系统中发音词典的使用可以看作是共享音素识别和单词识别任务的多任务学习。更多先进的语音识别的框架已经将这个方向推得更远。这些框架使用比音素更好的单元,从分层的语言结构中完成原始语音的声学信息到语义内容的过渡。例如,基于检测(detection-based)和丰富知识(knowledge-rich)的语音识别建模框架,使用了称为“语音属性”(speech attributes)的语音原子单元。而深度学习的方法使得该类识别方法的精度已经得到了很大的提升。

在自然语言处理领域,研究是多任务学习最典型的例子。一系列不同的“任务”,词性标注、组块(chunking)、命名实体标注、语义角色辨识和相似词辨识,均可使用一个通用的词表示和一个统一的深度学习方法来完成。

最后,深度学习在图像/视觉领域单模态的多任务学习上也是非常有效的。Srivastava和Salakhutdinov等人提出了应用在不同图像分类数据集上的一个DNN系统,这一系统是基于分层贝叶斯先验的多任务学习系统。深度神经网络和先验结合在一起,通过任务之间信息的共享和在知识转移中发现相似的类别,提高了判别学习的性能。具体来说,他们提出了一个联合学习图像分类和层次类别的方法,比如对那些训练样本相对少的“缺乏数据类别”,可以从相似且拥有较多训练数据的“数据丰富类别”中获得帮助。这个工作可以看作是学习输出表示很好的例子,这个例子和学习输入表示都是目前所有深度学习研究所关注的。

Ciresan等人将深度卷积神经网络架构应用到了拉丁文和中文的字符识别的工作中,这是图像领域的单模态多任务学习的一个实例。在中文字符上训练得到的卷积神经网络可以很轻易地识别大写拉丁字母。此外,可以通过先对所有类别上的一个小的子集做预训练,然后训练所有类别,对中文字符的学习进行加速。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。