监督分类(Supervised Classification),又称训练场地法。该方法基本思想是:首先从需要研究的区域选取有代表性的训练场地作为样本,根据已知的样本求解特征参数,确定判别函数和相应的判别准则,依此来计算未知类别的样本观测值的函数值,再按照判别准则进行所属类别的判别。

监督分类的主要步骤包括:首先需要从研究区域选取有代表性的训练场地作为样本;根据已知训练区提供的样本,通过选择特征参数(如像素亮度均值、方差等),建立判别函数,据此对样本像元进行分类,依据样本类别的特征来识别非样本像元的归属类别。监督分类的关键是训练样本和训练场地的选择,其选择的质量关系到分类能否取得良好的效果(闫琰,2011)。

监督分类的优缺点如下(杨鑫,2008)。

(1)监督分类的主要优点:①可根据应用目的和区域,有选择地决定分类类别,避免出现一些不必要的类别;②可控制训练样本的选择;③可通过检查来决定训练样本是否被精确分类,从而避免分类中的严重错误;④避免了非监督分类中对光滑集群组的重新归类。

(2)监督分类的缺点:①由于人为因素,分类系统的确定、训练样本的选择,分析定义的类别也许并不是图像中存在的自然类别,致多维数据空间中各类别间并非独一无二,而是有重叠,分析者所选择的训练样本也可能并不代表图像中的真实情形;②由于图像中同一类的光谱差异,如同一森林类,由于森林密度、年龄、阴影等的差异,其森林类的内部方差大,造成训练样本没有很好的代表性;③训练样本的选取和评估需要花费较多的人力和时间;④只能识别训练样本中所定义的类别,若某类别由于训练者不知道或者其数量太少未被定义,则监督分类不能被识别。

根据判别函数和判别规则的不同,监督分类的主要方法有:最大似然法、神经网络分类法、模糊分类法、最小距离分类法、平行六面体法、支持向量机分类法等。

(一)最大似然法

最大似然法(Maximum Likelihood Classification,MLC)通过对感兴趣区域的统计和计算,得到各个类别的均值和方差等参数,从而确定一个分类函数,然后将待分类图像中的每一个像元代入各个类别的分类函数,将函数返回值最大的类别作为被扫描像元的归属类别,从而达到分类的效果。

设在n维特征空间Qx(xi,i=1,2,…,n)中有m个模式类;kj,j=1,2,…,m,假定特征向量X对每个模式类的条件概率密度p(X/ki)和每个模式类kj的先验概率P(ki)均为已知,则最大似然法建立的判别函数集为(刘东林,1998):

![]()

在实际操作中,利用各类的均值及协方差矩阵和对数形式,该判别函数可进一步表示为:

![]()

判别函数的意义在于第i模式类中的点对于第i模式类的判别函数的值大于它于任何其他模式类别函数在该点的值,即:

![]()

从而,对于一个未知类别的像元X,我们就可以利用式(3-11)计算它属于各类的概率,然后比较这些概率,找出最大似然所属的类别,则X即应归入该类。

在众多的基于统计模式的遥感图像分类方法中,最大似然法有着严密的理论基础,对于呈正态分布的类别判别函数易于建立,综合应用了每个类别在各波段中的均值、方差以及各波段之间的协方差,有较好的统计特性,一直被认为是较先进的分类方法。但最大似然法是基于Bayse判别,它要求数据符合高斯正态分布,而实际的遥感数据往往是近似正态分布。对于这种近似正态分布的遥感数据,研究中通常将之按着高斯正态分布来处理,因而分类结果往往欠佳(吴连喜,2003)。

(二)模糊分类法

模糊分类是把任意范围的特征值转换为0~1之间的模糊值,这个模糊值表明了隶属于一个指定类的程度。通过把特征值翻译为模糊值,即使对于不同的范围和维数的特征值组合,模糊分类能够标准化特征值。模糊分类也提供了一个清晰的和可调整的特征描述(颜宏娟,2008)。

在模糊分类中,训练样本数据可用一个模糊分割矩阵来表示。设训练样本总数为n,特征数(波段数)为m,G为预先确定的类别数,则训练样本的模糊分割矩阵为(尤淑撑,2000):

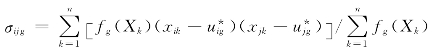

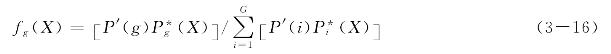

式中,fi(Xj)表示像元Xi对第i列的隶属度。若把每一列中最大值改为1,其他改为0,就成为一般的硬分割矩阵,也就是常规的训练样本数据。由模糊分割矩阵即可得到各类地物的模糊均值和模糊协方差矩阵。第g类模糊均值向量为:

![]()

式中, ;其中,xik为第i波段第k样本点亮度值。

;其中,xik为第i波段第k样本点亮度值。

模糊协方差矩阵为:

式中,

设P′(g)为第g类出现的先验概率,则像元X隶属于g类的隶属函数为:

式中,

模糊分类法的最后结果是各类别的隶属度图像,称其为软分类图像(称常规分类结果为硬分类图像)。根据最大隶属度原则,可将软分类图像转化为硬分类图像,设像元(i,j)软分类输出矢量μij=(μij(1),μij(2),…,μij(k)),其中k为类别数,μij(k)表示像元(i,j)对第k类的隶属度,如果μij(h)=maxμij(n)(n=1,2,…,k),则将像元(i,j)判为第h类。硬分类图像可满足制图和硬拷贝等需求。软分类图像可以提高面积统计和其他定量分析精度。

模糊分类提供了处理不精确信息的强有力的原理和工具。地物类别的信息是通过模糊数学的方法提取的,相比于人工神经网络等其他方法来说,它是一种对类别进行透明和适应性描述的技术。模糊分类法的关键在于确定隶属度或隶属函数,然而这一过程比较复杂,至今没有一般性的法则可以遵循,这是模糊分类法的缺点。另外,模糊分类是基于对图像进行分割后进行的,所以模糊分类的精度还直接取决于图像分割的精度(颜宏娟,2008)。

(三)最小距离法(https://www.xing528.com)

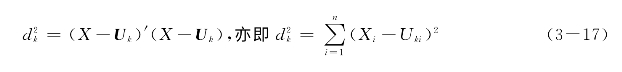

最小距离法利用训练样本数据计算出每一类的均值向量和标准差向量,然后以均值向量作为该类在特征空间中的中心位置,计算输入图像中每个像元到各类中心的距离,到哪一类中心的距离最小,该像元就归入到哪一类(冯登超,2012)。最小距离分类器的基本思想是根据训练集按照算术平均生成一个代表该类的中心向量Uk(k=1,2,…,m;m是类的个数),对于每一个待分类数据元组X,计算其与Uk之间的距离 ,最后判定X属于与之距离最近的类。这里X=[x1,x2,…,xn,c],Uk=[Uk1,Uk2,…,Ukn,c],c表示类别,c属于{c1,c2,…,cm}。最小距离分类器经常使用以下距离(任靖,2005)。

,最后判定X属于与之距离最近的类。这里X=[x1,x2,…,xn,c],Uk=[Uk1,Uk2,…,Ukn,c],c表示类别,c属于{c1,c2,…,cm}。最小距离分类器经常使用以下距离(任靖,2005)。

1.欧氏距离(Euclidian Distance)

2.标准化欧氏距离(Normalized Euclidian Distance)

![]()

式中,σii表示第k类所有数据元组属性的值得方差(i=1,2,…,n)。

3.马哈利诺贝斯距离(Mahalanobis Distance)

![]()

式中,σii表示第k类所有数据元组属性的值得方差(i=1,2,…,n),σij表示第k类所有数据元组属性和属性的协方差(i=1,2,…,n;j=1,2,…,i≠j)。

最小距离方法简单易行,实用性强,分类精度较高。但最小距离法分类精度一般来说,取决于已知地物类别的多少以及各类的散布情况。当类别较多,某些类的波谱数据散布较大时,分类效果往往不高。

(四)人工神经网络

人工神经网络,是以模拟人体神经系统的结构和功能为基础而建立的一种信息处理系统。人体神经网络由神经细胞,即神经元组成。一个神经元与多个神经元以突触相连,进入突触的信号作为输入(激励),通过突触而被“加权”,所有输入的加权之和即为所有权重输入的总效果。若该和值等于或大于神经元阈值,则该神经元被激活(给出输出),否则即不被激活(张宝光,1998)。

仿照人体神经元的连接结构,将结点组合连接成层。各层组合连接成网络,即为人工神经网络模型。由于人脑神经网络系多层次结构,且结点连接多属前馈连接,最先推出的人工神经,网络模型属等馈层次网络模型。初期,这种网络模型为简单感知器(即一层感知器),而后,为含有稳蔽层的多层感知器。目前,作为多层感知器类型的反向传播网络(简称BP网络)已成为应用最为广泛的人工神经网络模型之一。

人工神经网络与传统统计方法相比,具有并行处理、自适应、非线性动力机制等优势;当特征空间分布很复杂时,或者源数据各维具有不同的统计分布和尺度时,也能获得理想的分类结果。但人工神经网络在实际应用中也存在一些限制,如局部极小、学习效率低、网络结构难以确定等(骆剑承,2001)。

(五)平行六面体法

平行六面体分类采用非参数方法,它不要求数据有高斯分布,但要求特征空间中线性判别平面平行于特征轴。此方法难于使特征空间中交叉类别分离,确定平行六面体的判别界线也严重依赖于人为判断,所以比许多其他分类方法更受人们的误识影响(朱建国,1995)。平行六面体是指根据训练样本的亮度值形成一个n维平行六面体的数据空间,其他像元的光谱值如果落到任何一个训练样本所对应的区域,就被划为其中。平行六面体尺度由标准差阈值所确定,标准差阈值则根据所选类别的均值确定(金杰,2014)。

目前每种方法都有分类的局限性,没有哪一种是绝对最好的。因此必须针对具体问题,灵活应用,综合应用多种分类方法。

(六)支持向量机分类法

支持向量机,是统计学习理论中最年轻的内容,也是最实用的部分。其核心内容是在1992到1995年间提出的,目前仍处在不断发展阶段。支持向量机是建立在统计学习理论基础上的一种数据挖掘方法,能非常成功地处理时间序列分析、分类问题、判别分析等诸多问题(丁世飞,2011)。

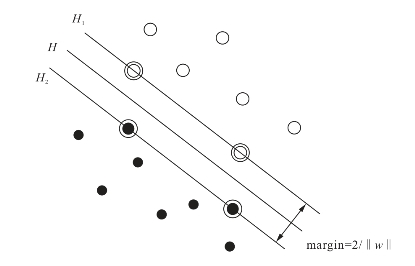

支持向量机SVM是从线性可分情况下的最优分类面发展而来的,基本思想可用图3-1的二维情况说明。图中,实心点和空心点代表两类样本,H为分类线,H1,H2分别为过各类中离分类线最近的样本且平行于分类线的直线,它们之间的距离叫作分类间隔(margin)。所谓最优分类线就是要求分类线不但能将两类正确分开,而且使分类间隔最大。H1,H2上的训练样本点就称作支持向量。

图3-1 线性可分情况下的最优分类线

概括地说,支持向量机就是首先通过用内积函数定义的非线性变换将输入空间变换到一个高维空间,在这个空间中求最优分类面。SVM分类函数形式上类似于一个神经网络,输出是中间节点的线性组合,每个中间节点对应一个支持向量,如图3-2所示。

图3-2 支持向量机示意图

支持向量机有很多优点,如基于结构风险最小化,克服了传统方法的过学习(Overfitting)和陷入局部最小的问题,具有很强的泛化能力;采用核函数方法,向高维空间映射时并不增加计算的复杂性,又有效地克服了维数灾难(Curse of Dimensionality)问题。但同时也要看到目前SVM研究的一些局限性,包括以下几项。

(1)SVM的性能在很大程度上依赖于核函数的选择,但没有很好的方法指导针对具体问题的核函数选择。

(2)训练和测试SVM的速度和规模是另一个问题,尤其是对实时控制问题,速度是一个对SVM应用的很大限制因素。

(3)现有SVM理论仅讨论具有固定惩罚系数C的情况,而实际上正负样本的两种误判造成的损失往往是不同的。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。