1.项目需求

1)一期数据中心区域总建筑面积不少于20000m2,机房净使用面积不少于4000m2。由于园区一期供电接入限制,IT设备运行功率在一期约为5000kW。

2)二期数据中心区域总建筑面积不少于50000m2,机房净使用面积不少于10000m2。IT设备运行功率不低于15000kW(本节只介绍一期项目)。

3)采用Uptime Institute TierIV。

4)PUE小于1.6。

2.项目限制条件

1)园区根据控规条件,数据中心建筑高度在24m以下。

2)鉴于市政给水接入不足,二期计划使用中水。

3.技术方案论证

(1)平面改进方案

方案一:首层设置柴油发电机、低压配电房间、UPS室、电池间、电信接入间,二层为高压配电室、IT机房,三、四层为IT机房,机柜净使用面积约为4800m2,IT运行功率为4800kW,缺点为A、B路由无法隔离,不满足TierIV标准。

方案二:首层设置柴油发电机、IT机房、电信接入间,二层为高压配电室、变压器室、UPS室、电池间、IT机房,三层为变压器室、UPS室、电池间、IT机房,四层为变压器室、UPS室、电池间;IT运行功率为5180kW,机柜净使用面积约为4400m2,满足TierIV标准。

(2)电气方案演进 UPS系统2N和2(N+1)方案论证:

从数据中心空间上2N和2(N+1)对应的IT运行功率为5180kW和3880kW,从两种配电系统上可靠性提升对整体系统几乎没有影响,为得到更多IT运行功率选择2N UPS配电系统。

(3)空调方案演进

1)风冷直膨空调。原有机房一直使用风冷直膨空调,运维体系健全完善,人员经验也非常丰富,采用风冷直膨空调的劣势是运行能耗过高,优势是不需要考虑缺水停水。

2)水冷冷水系统。采用水冷冷水系统的优势是能耗较小,劣势是人们缺乏对水系统的了解,同时同行业案例较少。

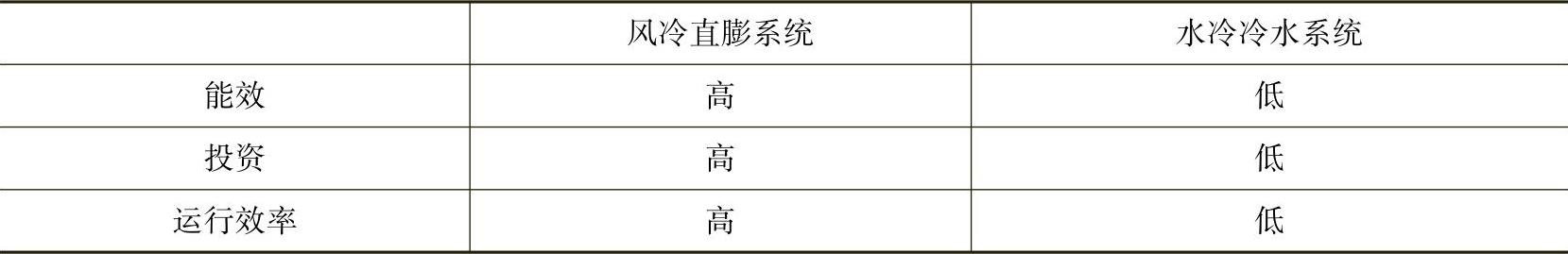

通过水冷冷水系统和风冷直膨系统在能效、投资、运行方面进行比较,见表10⁃1。本案例采用风冷直膨系统+水冷冷水系统的2N架构,既考虑运行过程中的高效节能,同时确保市政给水故障时制冷系统不受影响。

表10⁃1 能效、投资、运行效率比较

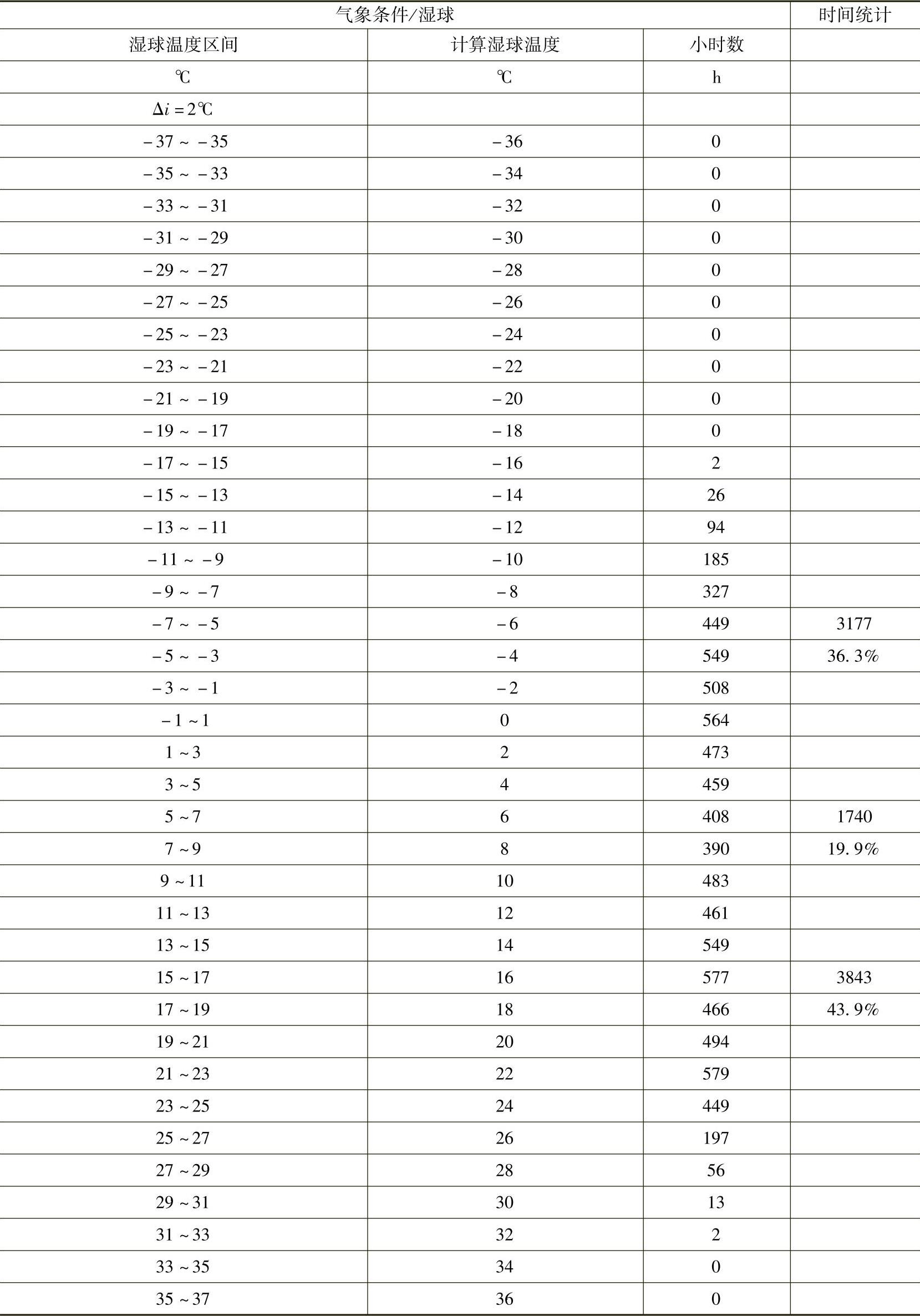

3)自然冷却技术。自然冷却北京地区全年小时数统计见表10⁃2。

表10⁃2 自然冷却北京地区全年小时数统计(https://www.xing528.com)

数据来源:中国国家气象局《中国建筑热环境分析专用气象数据集》2006年以来北京地区典型气象年逐时参数报表。

由表10⁃2可以看出,每年可以利用部分自然冷却的小时数为1740h,完全自然冷却的小时数为3177h。总结以上自然冷却使用率,可得出至少节约46%制冷能耗。

由此可见,水冷系统在自然冷却的运行模式下节能的效果是非常显著的。

4.项目节能措施

数据中心能耗较高,应采取各种措施降低能耗,暖通系统采取的具体措施包括:

1)提高冷冻水的供水温度。

2)采用自然冷却系统。

3)采用冷热通道方式,冷热通道设定不同温度。不采用机房温度23℃±1℃,采用冷通道18℃±2℃,热通道29℃±2℃,制冷系统能耗节约约为15%。

4)采用湿膜加湿。

5)改善精密空调系统。

6)采用水冷冷水系统。

7)冷却塔风机变频驱动。

8)机房用精密空调采用变频风扇。

5.项目总结

1)采用TierIV设计标准(无单点故障、连续制冷)。

2)PUE小于1.5。

3)高架地板面积与总建筑面积比为1∶4.54。

4)任意设备可任意时间就位或运离建筑。

该银行数据中心尝试新的制冷方式,在运行过程中累计水冷冷水系统运行经验,为后期数据中心设计、建设、运行打下坚实的基础。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。