在基于内容的图像检索(Content-Based Image Retrieval,CBIR)技术出现之后,基于内容的音频检索也开始受到关注,其中有大量的研究是关于基于例子的音频检索。与CBIR研究类似,基于例子的音频检索探讨如何通过对底层听觉特征的分析和理解,比较用户提交的查询例子与数据库中音频样本的相似度,从而返回给用户与查询例子相似的音频。这类研究力求通过机器学习、统计分析等方法,理解底层特征所蕴含的潜在语义,使得检索结果尽可能地具有一定的语义相似性。

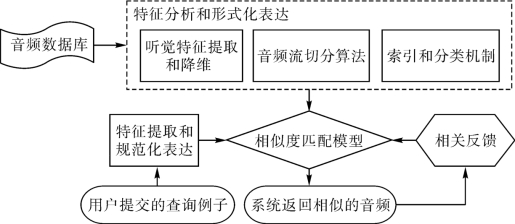

如图5-3所示,基于例子的音频检索一般包括如下几个步骤:特征分析和形式化表达、相似度匹配和相关反馈,其中,特征分析和形式化表达是最基础的部分,直接影响相似度计算的准确率,它又包括听觉特征的提取和降维、音频流的切分、索引和分类机制。

(https://www.xing528.com)

(https://www.xing528.com)

图5-3 基于例子的音频检索流程图

音频包括语音和非语音两种信号。基于例子的音频检索主要是针对非语音信号,如:音乐、动物的声音、环境音等;而语音信号一般是用来做识别研究,如:字、词、短语的识别。例如:美国卡耐基梅隆大学(Carnegie Mellon University)的Informedia项目曾对视频流中的语音信号进行识别研究,将语音信息转换成文本,以此来对视频流进行索引和检索。

除了基于内容的方法之外,也有很多人关注基于文本的音频检索,即:通过人工标注的形式,对音频数据进行注释和索引,然后通过文本匹配实现用关键字检索音频。但是,这种方法存在一些缺点:人工标注费时费力,又存在歧义性;音频往往数据量较大、语义丰富,难以用人工的方式主观地标注,例如:一段30min的音频,很可能蕴含了多个语义信息,不同的人进行标注将会得到不同的标注结果。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。