【摘要】:未来要使××系统能正常运行,需要准备Spark 集群、Spark日志管理系统、Kafka 分布式消息队列等环境,这里默认集群中已经安装好了部分大数据组件,例如Hadoop、ZooKeeper、Hive、Flume 等。根据项目经理对工作的安排,从第一项工作开始,搭建Spark 集群系统,为数据处理提供支撑平台。

【项目描述】

模拟一个大数据实时处理项目开发需要的环境,正式开启大数据实时分析系统的环境搭建。

假设,将自己的角色定义为××系统的运维人员,我们需要进行不断的学习和训练来完成项目组分配给我们的工作。

【项目分析】

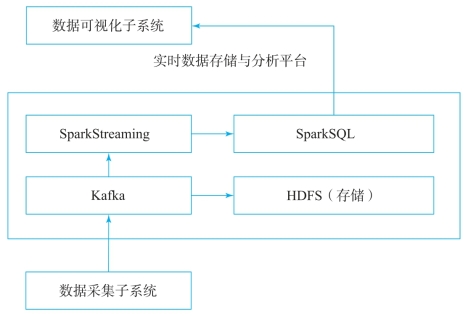

通过需求分析工程师、软件设计工程师的工作,已经对系统进行了整体的设计,系统由数据采集模块、数据缓冲模块、数据处理模块三个子模块构成,其中数据采集模块使用Flume,数据缓冲模块使用中间件Kafka,数据处理模块使用SparkStreaming。系统结构如图2-1 所示。

图2-1 系统结构(https://www.xing528.com)

作为系统运维组成员,项目经理分配的工作有如下几项:

①搭建Spark 集群系统,为数据处理提供支撑平台(项目二内容)。

②Spark 基于Yarn 的运行配置,为spark on yarn 提供平台支撑(项目三内容)。

③搭建Spark 历史日志系统,为查看日志提供平台支撑(项目四内容)。

④搭建Kafka 消息系统,为××系统的数据缓存提供支撑平台(项目五、项目六内容)。

××系统生产环境用于支持项目的上线运行,应保证其高可靠性,并提供自动化运行能力。未来要使××系统能正常运行,需要准备Spark 集群、Spark日志管理系统、Kafka 分布式消息队列等环境,这里默认集群中已经安装好了部分大数据组件,例如Hadoop、ZooKeeper、Hive、Flume 等。

根据项目经理对工作的安排,从第一项工作开始,搭建Spark 集群系统,为数据处理提供支撑平台。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。