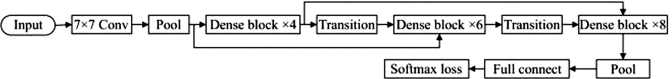

康奈尔大学、清华大学、Facebook FAIR实验室合作在2016年提出了密集卷积神经网络(DenseNet),并且在多个数据集验证了其特征重用和降低梯度消失的特性,同时验证了40、250层网络结构的表现。其中图9-10为40层密集卷积神经网络结构。首先将图像输入卷积核为7×7的卷积层获取图像特征图;再经过池化窗口为3×3,步长设为2的最大池化层简化网络计算复杂度;之后为进一步改善层与层之间的信息流,通过密集连接将密集块(dense block)连接起来,每个密集块中包含卷积核为1×1和3×3的卷积层。到第XL层时如图9-10所示,XL层接收所有以前x0,x1,…,xn-1层的特征图,即将等式中多个输入变为单个张量,如公式![]() 其中复合函数XL表示批量归一化(BN)、整流线性单元(ReLU)、池化(pool)以及3×3卷积(Conv)的复合操作;另外密集块之间使用过渡层(transition layer)降低输出维数,过渡层进行卷积和池化。通过控制卷积核数量通道数,可以帮助减少模型参数;随后经过池化层得到网络特征,最后通过softmax函数输出识别结果这种密集连接模式的优势:不需要重新学习冗余特征图,比传统卷积网络具有更少的参数。传统的前馈架构可以被视为具有状态的算法,从一层传递到另一层每层从上层读取状态并写入后续层,后续层得到前层特征。许多卷积层的特征图贡献很少,因此可以在训练过程中随机丢弃。密集卷积神经网络明确区分了添加到网络的信息和保留的信息它是通过特征重用来提高网络的潜力,产生易于训练和高度参数化的精简模型。

其中复合函数XL表示批量归一化(BN)、整流线性单元(ReLU)、池化(pool)以及3×3卷积(Conv)的复合操作;另外密集块之间使用过渡层(transition layer)降低输出维数,过渡层进行卷积和池化。通过控制卷积核数量通道数,可以帮助减少模型参数;随后经过池化层得到网络特征,最后通过softmax函数输出识别结果这种密集连接模式的优势:不需要重新学习冗余特征图,比传统卷积网络具有更少的参数。传统的前馈架构可以被视为具有状态的算法,从一层传递到另一层每层从上层读取状态并写入后续层,后续层得到前层特征。许多卷积层的特征图贡献很少,因此可以在训练过程中随机丢弃。密集卷积神经网络明确区分了添加到网络的信息和保留的信息它是通过特征重用来提高网络的潜力,产生易于训练和高度参数化的精简模型。

(https://www.xing528.com)

(https://www.xing528.com)

图9-10 密集卷积神经网络结构示意图

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。