ImageNet已经成为全球最大的图像识别数据库,每年一度的比赛也牵动着各大巨头公司的心弦,如今图像识别已经能做到很高的水准。下一步是图像理解,要把语义和图像结合起来,推动人工智能的进一步发展。一个叫Visual Genome的图像数据库,可能会推动计算机实现这个目标。它由斯坦福计算机视觉教授、人工智能实验室主任李飞飞和几个同事开发。Visual Genome是后ImageNet时代计算机视觉在理解图片上的训练和测试数据集。Visual Genome的官方网站上(网站:https://visualgenome.org)把它定义为:Visual Genome是一个数据集、知识库,不断努力把结构化的图像概念和语言连接起来。

目前包含:108 249张图片,420万对区域的描述(Region Descriptions),170万视觉问答(Visual Question Answers),210万对象案例(Object Instances),180万属性(Attributes),180万关系(Relationships),所有的东西都映射到Wordnet Synsets。

教会计算机解析视觉图像是人工智能非常重要的任务,这不仅能带来更多有用的视觉算法,而且也能训练计算机进行更为高效的沟通。毕竟,在表达真实世界的时候,语言总是受到很大的限制。尽管在感知的任务上(如图像分类)计算机有很多进展,但是在认知的任务上(如图像描述和问答)计算机表现得不怎么样。如果不仅仅诉求识别出图像,而要深究视觉世界的意义,那么认知是最核心的任务。被用于解决图片内容丰富的认知任务的模型,依然使用给感知任务设计的相同数据集来训练。要在认知任务中获得成功,模型需要理解对象和物体之间的交互和关系。当问到:“这个人正在骑着什么交通工具?”的时候,计算机需要识别出图片中的物体以及里面的关系“骑行”(人、马车)和“拉车”(马、马车),这样才能正确回答“这个人正坐着马车”。

ImageNet包含了超过100万张图片的数据集,里面的内容都有很好的标记。每年ImageNet大规模视觉识别挑战赛都会测试计算机在自动识别图像内容的能力。Visual Genome的图像要比ImageNet的图像标签更为丰富,包括名字、图片的不同细节以及在对象和动作信息之间的关系。该数据集包括了超过10万张图片,每一张图片都包含了平均21个对象、18种属性和18种物体之间的关系。规范化了从对象、属性、关系、区域描述里的名词、短语和问答对到WordNet同义词集的关系。这些注释代表了图像描述、属性、关系和问答里最密集、规模最大的数据集。

计算机视觉领域的圣杯,是完全理解图像里的场景:一个能够命名并且检测物体的模型,描述它们的属性,识别出它们的关系和交互。理解场景会带来重要的应用,例如图片搜索、问答、机器人交互等。为了实现这个目标,最近几年已经有了很大的进展,包括图片的分类任务和对象识别。

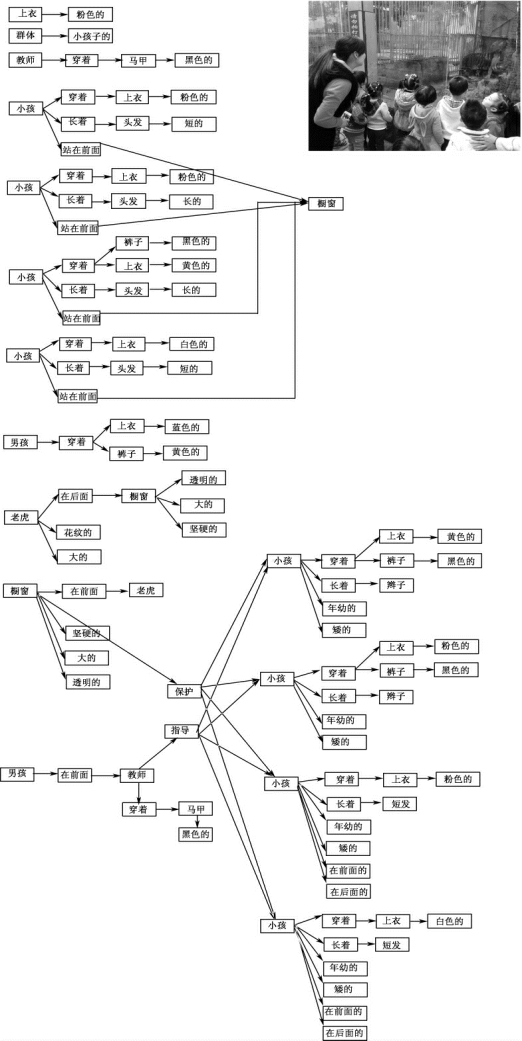

对数据的总体概述,需要从感知图像到认知理解图像。图8-16呈现了一组图像数据集,其区域描述、对象、属性和关系都有密集的注释。区域描述(例如“小孩喂食斑马”和“一个妇女在小孩后面照相”)被表示在图的上部分。对象(斑马)、属性(斑)和关系(喂食)表现在图的下部分。数据集也包含了和问答相关的图片。

图8-16 视觉基因组数据的总体概述

大规模数据的可利用性是起作用的一个重要因素,并且驱动了统计模型构成了计算机视觉理解进展的基础。虽然取得了一定的进展,但距离理解图像的目标还有很远的距离。

图8-16中所示,现有的模型可以挖掘出相片中潜在的物体,但是没有能力来解释他们之间的交互和关系。解释性的行为更加倾向于对自然界的认知过程,整合感知到的信息得出关于图片中物体间关系的结论。对视觉世界的认知理解过程,需要在计算机识别物体的能力以外,补充描述物体并且理解他们之间的交互关系。

把下一代的数据集整合到一起来服务于深度认知图像理解任务的训练和基准测试中,其中最有名的是MS-COCO和VQA。MS-COCO数据集中包含了从Flickr收集到的30万张真实世界中的照片。每一张照片都在像素级别分割成91种对象级别和5个独立的用户生成的句子来描述照片中的场景。VQA给相关照片的视觉内容加上了61.4万的问答对。在这些信息下,MS-COCO和VQA为致力于精准物体识别、分割以及图片的总结性文字和基础的问答任务的模型提供了多样的训练和测试基础。例如,最前沿的模型提供了对MSCOCO的图片的描述,但关于进一步理解各个对象在哪里、每个人都在做着什么、之间的关系是什么都没有描述。没有这种关系,整个模型是没办法把物之间的关系区别开来的。

为了更加彻底地理解图像,对于现有数据集,需要进行以下三方面的关键工作:把视觉概念落实到语义层面;基于多区域图片的完整性的描述和问答;图片组成的形式化表示。

为了把视觉世界里面的完全信息映射出来,可以参考Visual Genome数据集。Visual Genome数据集第一次发布了108 249张图片,是YFCC100M和MS-COCO的交集。Visual Genome数据集把关系和属性作为重要对象对待。对于完全理解一张图片来说,对关系和属性的识别是十分重要的部分,在很多例子中,这些部分是讲述场景故事的关键所在(例如,“一只老虎追着兔子跑”和“兔子追着老虎跑”的不同)。Visual Genome是第一个提供物体间的交互和属性详细标签,将视觉概念落实到语义层面的数据集。

一般来说,很难用一个句子来描述一张有丰富场景的图片。图8-16中包含了很多故事:“一个小孩正在喂食两只斑马”“一个妇女正在拍摄照片”“黄色的草地上长着树”等。现有的数据库例如Flickr 30K和MS-COCO主要针对图像进行高层次的描述。而对于Visual Genome数据集里的每一张图片,有针对不同区域的42种描述,提供了更加密集和完全的图像描述。除此之外,在VQA的激发下,根据对每张图片的描述平均收集到17种问答对。NLP和视觉模型的发展可以利用基于区域的问答和描述来回答问题。

Visual Genome数据集通过对图片进行密集描述、视觉像素(对象的界限)和文字描述(关系、属性)的明确对应,现在是第一个能够提供结构化的对图片进行形式化表示的数据集,可以大量用于NLP的基于知识的展示中去。例如在图8-16中,“喂食”这个关系涉及小孩和斑马,可以作为一种表达。每幅图片都可以看做是场景图,将其中所有的对象和对象所在图片中的关系放在一起。场景图展示用于提高语义图片检索,并且为图片加上说明。再进一步讲,Visual Genome数据集里面的任何一张图片的所有对象、属性和关系都会建立和Word-Net的规范化映射。这种映射关系连接了所有Visual Genome图片,并且提供了有效的方法来对数据集中相同的概念(对象、属性或关系)进行一致提问。同时也能帮助训练模型,可以从多张图片的上下文信息中学习。

未来,基于Visual Genome数据集的可视化模型、API以及其他信息可以在线获取。图8-17展示了3个区域描述以及它们相对应的区域。同时也展示了通过结合所有的图像区域图收集到的连通图。顶部区域图描述了一个妇女和一个小孩站在沙滩前面的海水里。它包含了这些对象:妇女,小孩,沙滩以及海水。连接这些对象的关系有:站在(妇女,海水),在…之前(妇女,沙滩),站在(小孩,海水),穿着(小孩,粉色上衣)。

图8-18中的各个对象(小孩、老师、橱窗等)的边框没有被展示出来。这些对象也有一些属性:粉色的,前面,后面等。通过关系(穿着(小孩、上衣),指导(老师、小孩))等将对象间的关系连接起来。

图8-17 区域描述

图8-18 场景图描述

图8-19中,每张图包含多个局部图像描述的区域描述。其中收集到两种类型的问答组:基于区域的问答组和自由形式的问答组。每个区域分别被转化为基于属性的区域图表描述、基于对象的区域图描述以及基于成对关系的区域图表述。最后,将这些区域图表述连通起来,生成一个基于图像的所有对象的场景图表述。

图8-19 数据集表述

Visual Genome数据集包括7个主要部分:区域描述、对象、属性、关系、区域图、场景图和问答对。图8-19展示了一幅画的每一个部分的例子。要对图像进行理解的研究,从收集描述和问答对开始。这些是原始的文本,没有任何长度和词汇的限制。下一步,从描述中提取对象、属性和关系。这些对象、属性和关系一起构造了场景图,这代表了一般的图像。

1)多区域和对它们的描述

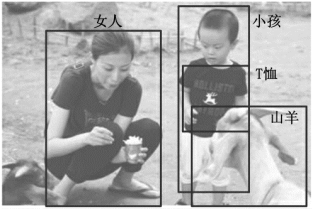

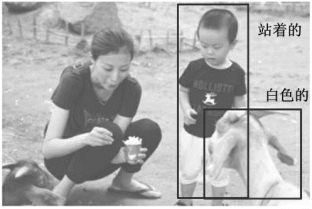

一个简单的总结往往不足以描述真实世界图片里的所有内容和交互,一个自然的扩展方法是对图像的不同区域分布进行描述。在Visual Genome中,收集了人们对图像不同区域的描述,不同的区域用边框进行坐标限定。图8-20展示了按照区域描述的3个案例。不同区域之间允许有高度的重复但描述会有所不同。例如,“白色山羊”和“小孩穿着黑色T恤在女人旁边站着”重叠部分很少,但是“女人喂食山羊”跟其他两个区域重叠率很高。数据集中对每张图片评价有42种区域描述,每个描述都是一个短句。

(https://www.xing528.com)

(https://www.xing528.com)

图8-20 人工标注的区域描述

2)多个物体与它们的边框

在数据集中,评价每张图片包含21个物体,每个物体周围有一个边框(见图8-21)。并且,每个物体在WordNet中都对应一个规范化的ID。比如,man和person会被映射到man.n.03|(the generic use of the word to refer to any humanbeing);相似的,person被映射到person.n.01(a humanbeing)。随后,由于存在上位词man.n.03,这两个概念就可以加入person.n.01中了。这是一个重要的标准化步骤,以此避免同一个物体有多个名字(比如,man,person,human),也能在不同图片间实现信息互联。

图8-21 区域中的物体描述

图8-20中,Visual Genome数据集中包括了数条人类标注的区域描述,每个区域用边框界定,来描述图片中所有的内容物和相互间的关系。这里有3个区域描述:“小孩穿着黑色T恤在女人旁边站着”“白色山羊”以及“女人喂食山羊”。

3)一组属性

Visual Genome中,每张图片平均有16个属性,一个物体可以有0个或多个属性。属性可以是颜色(比如白色),状态(比如站着)等(如图8-22)。正如可以从区域描述中提取物体一样,也可以提取这些物体自身的属性。在图8-22中,在短语“白色山羊”中,可以提取到“山羊”有“白色”属性。和物体一样,也把属性在WordNet中规范化,比如,yellow被映射到yellow.s.01(of the color intermediate between green and orange in the color spectrum;of something resembling the color of an egg yolk)。

4)一组关系

“关系”将两个物体关联到一起,可以是动作(比如站着),空间位置(比如在旁边),动词(比如穿),介词(在),比较词(比如比……更高),或者介词短语。例如,从区域描述“女人喂食山羊”中,提取到物体“女人”和物体“山羊”之间的关系是“喂食”,见图8-23)。这些关系是从一个物体(也叫主体)指向另一个物体(也叫客体)的。这个例子中,主体是“女人“,她正在对客体“山羊”表现出“喂食”的关系。每个关系也在WordNet中有规范化的synset ID:jumping被映射到jump.a.1(move forward by leaps and bounds)。平均而言,数据集中的每张图片包含18个关系。

从所有的区域描述中提取涉及物体的描述。例如,从“女人喂食山羊”中,提取了“女人”和“山羊”。

一些描述也提供了物体的属性信息。例如,区域描述“白色山羊”中意味着“羊”的颜色是白色。在这里,展示了2种属性:“白色的”和“站着的”。

数据集也捕捉了图片中物体与物体之间的关系和交互。在这个例子里,展示了发生在“女人”和“羊”之间的“喂食”关系。

图8-22 物体属性信息

图8-23 物体关系与交互

5)一组区域图

将从区域描述中提取到的物体、属性以及关系结合在一起,每42个区域创造一幅有向图表征。

图8-19为区域图,每幅区域图是对图片的一部分所做的结构化表征。区域图中的节点分别代表物体、属性以及关系。物体同各自的属性连接,关系则是从一个物体指向另一个物体。图8-19中从主体物体用箭头指向关系,再由关系指向另外的其他物体。

6)全景图

区域图是对图片的某一区域的表征,将它们融合到一起成为一幅全景图,能够对整张图片进行表征。全景图包含每个区域描述中的物体、属性以及关系,是所有区域图的拼合。利用这种方式能够更加连贯地结合多个层次的全景信息。在图8-19中,最右边的区域表示“山羊是白色的”,中间的区域描述为“女人喂食山羊”。将这两个描述拼合到一起,可以表达为“女人喂食白色的山羊”。

7)一组问答

在数据集中,每张图片包括两类问答:基于整张图片的随意问答和基于选定区域的区域问答。每张图片收集了6个不同类型的问题:what,where,how,when,who以及why。图8-19中,“问,小孩站在什么旁边?答:一个女人”这是一个随意问答。每张图片的问题都包含了这6种类型的问答,每个类型中又至少包含1个问题。通过区域描述来收集区域问答。例如:“白色山羊”的描述中可以收集到的区域问答是:“问,山羊是什么颜色的?答:白色”。可以通过区域问答来独立地研究如何优先运用NLP和视觉来回答问题。

8)未来应用

前面已经分析了数据集的各个组成部分,并呈现了基于属性分类、关系分类、描述生成、问题对答等任务的实验结果。但数据集的应用远不止于这些,还能够用于更多的应用和实验任务中。在将来,视觉基因组数据技术在密集图像注释、视觉问答、关系提取、语义图像检索等方面有令人期待的应用前景。

9)结论

Visual Genome数据集提供一个多层次的图片理解方式,通过其可以多角度地对一幅图片进行研究:从像素级信息(如对象)到进一步推导出的关系模型,甚至到更深层次的认知任务(如视觉问答)。针对模型训练和确立下一代计算机视觉模型基准来说,Visual Genome是一个全面的数据集,希望通过这些模型能够建立起一个对视觉世界更广泛的理解。完善检测对象的计算机能力,同时,被检测到的对象也具备描述对象之间的相互作用和关系的能力。对于视觉理解,一个更加完整的描述集以及从视觉概念到语言的视觉问答模型来说,Visual Genome数据集是一个大型的、形式化的知识表述。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。