【摘要】:要对海量数据进行有效的分析,应该将这些来自前端的数据导入到一个集中的大型分布式数据库,或者分布式存储集群,并且可以在导入基础上做一些简单的清洗和预处理工作。通过大数据的预处理这一步骤,将这些结构复杂的数据转换为单一的或便于处理的结构,为以后的数据分析打下良好的基础。图2-3大数据处理流程大数据预处理的方法主要包括:数据清洗、数据集成、数据变换和数据规约。

要对海量数据进行有效的分析,应该将这些来自前端的数据导入到一个集中的大型分布式数据库,或者分布式存储集群,并且可以在导入基础上做一些简单的清洗和预处理工作。导入与预处理过程的特点和挑战主要是导入的数据量大,通常用户每秒钟的导入量会达到百兆,甚至千兆级别。

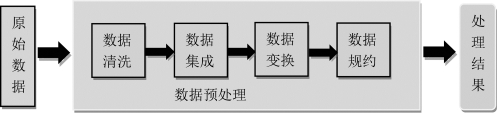

根据大数据的多样性,决定了经过多种渠道获取的数据种类和数据结构都非常复杂,这就给之后的数据分析和处理带来了极大的困难。通过大数据的预处理这一步骤,将这些结构复杂的数据转换为单一的或便于处理的结构,为以后的数据分析打下良好的基础。由于所采集的数据里并不是所有的信息都是必需的,而是掺杂了很多噪声和干扰项,因此还需要对这些数据进行去噪和清洗,以保证数据的质量和可靠性。常用的方法是在数据处理的过程中设计一些数据过滤器,通过聚类或关联分析的规则方法将无用或错误的离群数据挑出来过滤掉,防止其对最终数据结果产生不利影响,然后将这些整理好的数据进行集成和存储。现在一般的解决方法是针对特定种类的数据信息分门别类地放置,可以有效地减少数据查询和访问的时间,提高数据提取速度。大数据处理流程如图2-3所示。

(https://www.xing528.com)

(https://www.xing528.com)

图2-3 大数据处理流程

大数据预处理的方法主要包括:数据清洗、数据集成、数据变换和数据规约。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。