大多数传感器都是模拟信号输出,但计算机不能处理模拟信号,计算机只能处理数字信号,并且只能处理有限的数据。因此,需要将模拟信号转换成数字信号。这一步工作通常由模数转换器完成,最后输出用时间和幅值表示的已数字化的时域文件。模数转换器也就是我们通常所说的ADC。从模拟信号转换成数字信号,这一过程,称为采样或数据采集。

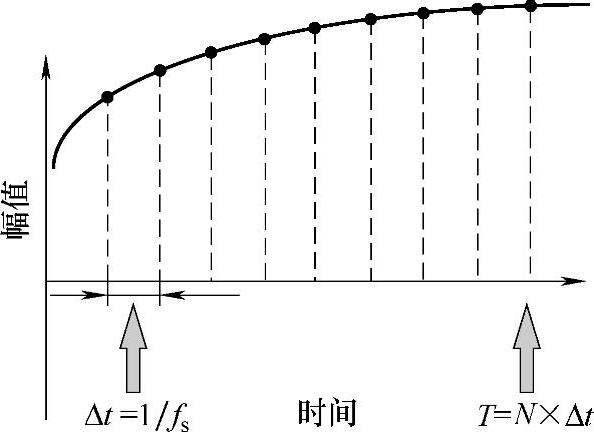

采样必须按一定的速率进行,那么采样频率就是用来表示采样的速率,用Hz表示。本质上,我更愿意称采样频率为采样率,因为它表征的是采样的快慢,采样率高,则采样快。采样率表示每秒钟采集多少个样本点(或数据点),用sample/s或样本点数/秒表示,如采样(频)率为1000Hz,则表示每秒钟采集1000个样本点,采样示意如图2-21所示,采两个样本点的时间间隔为1ms,这个时间间隔称为时间分辨率。时间分辨率为采样频率的倒数,时间分辨率越小,则采样频率越高,采集到的数字信号越接近真实信号。

图2-21 采样示意

与时间分辨率相对应的是频率分辨率,频率分辨率的倒数为做一次FFT所截取的时域数据长度T。这个时间长度T所对应的数据称为1个数据块(time block)或1帧。因此,在数据采集时,可以用时间表示总的采样长度,也可以用数据块或帧数表示总的采样长度。1个数据块包含N个数据点,因此,1个数据块的时间长度T=N×Δt。因此,也可以用总样本点数表示采样长度,但一般很少这样表示,因为,采样时间一长,这个总样本点数会很大。

信号采样过程中,最常见的两类误差是由采样频率和量化引起的,这两类误差可能大多数NVH工程师都知道。在这主要介绍采样频率带来的误差,其他误差,包括量化误差,还有一些可能你不知道的误差将在本章2.7采样过程中存在的误差一节中进行详细的介绍。

采样定理要求采样率至少是关心的最高频率的2倍,假设关心的最高频率为500Hz,则采样频率应至少为1000Hz。采样定理只是保证信号的频率不失真,但并没有保证信号的幅值不失真,如果按采样定理来设置采样频率,那么高频信号的幅值肯定会失真,低频信号的幅值也可能会失真。

采样频率越高,1s内采集的样本点(或数据点)越多,信号幅值越接近真实幅值。理论上讲,采样率越高越好,由采样率带来的误差会越小,但这并不现实。因为,一方面采样率受采集设备最高采样频率限制;另一方面,采样率越高,会导致采样的数据容量大增,出现大的数据文件。

采样的时域数据文件大小计算公式如下(采样时间以s为单位):(https://www.xing528.com)

数据总大小=通道数×采样频率×每个样本点的字节数×总的采样时间

不同的采集设备厂商每个样本点的字节数可能会有差异。如24位AD,LMS采用3字节存储,而DASP则采用4字节存储。假设16个通道,采样率为1024Hz采集1h,则LMS的数据大小为168.75MB,DASP为225MB。

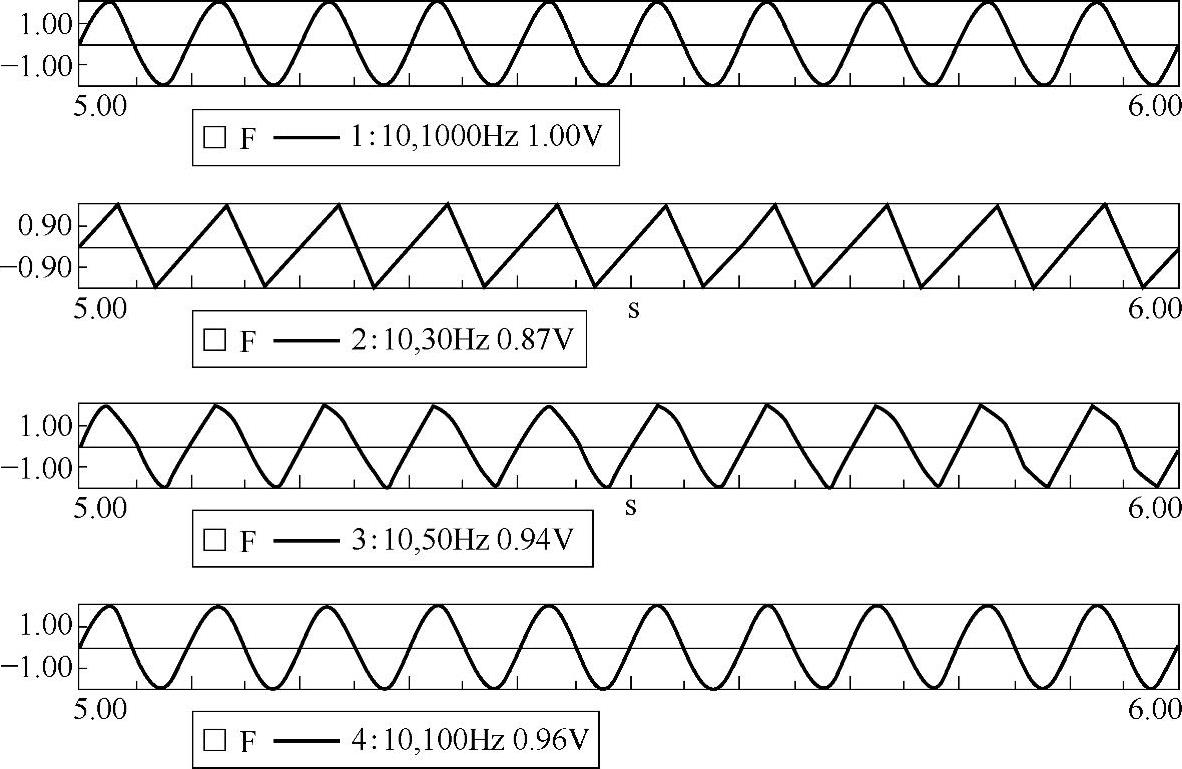

回到我们的主题问题,到底采样频率设置多大,采集到的时域信号的幅值才不失真或失真很小。下面将以一个频率为10Hz,有效值为1V的单频信号为例来进行说明。假设采样率为1000Hz(信号频率的100倍)采集到的信号幅值是没有明显失真的。对单频正弦波而言,如果刚好按采样定理来设置采样频率,那么采集到的信号幅值会严重失真,信号为三角波,因为一个周期内只能采集2个样本点。当采样频率3倍于信号频率时,采集到的信号有效值为0.87V。当采样频率5倍于信号频率时,采集到的信号有效值为0.94V。当采样频率10倍于信号频率时,采集到的信号有效值为0.96V。各个采样率下采集到的时域信号如图2-22所示。

图2-22 不同采样率下得到的信号幅值

从图1-22可以看出,不同的采样率下,信号的幅值是不同的,采样率越高,信号幅值失真越小。因此,一般来说,如果关心时域信号的幅值,那么采样频率应大于10倍的信号频率才不会引起明显的幅值失真。

对于瞬态冲击信号,为了捕捉到冲击瞬间的幅值,则要求采样频率更高。这就是为什么DASP在进行锤击法模态测试时,要使用变时基采样的原因所在。当采样频率提高之后,通过上面数据大小计算公式可以看出,数据必然变大。因此,在一些爆炸采集时,采样率可能高达MHz,这时为了降低数据容量,采用低位AD来进行采集,有可能用12位或16位AD。

总的说来,对于常规的振动噪声采集,如果关心幅值,宜用高位AD,如24位AD,同时采样频率应大于10倍的信号频率才不会引起明显的幅值失真。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。