基于深度神经网络的编-解码架构在自然图像描述生成方面取得的成功已经得到验证。本节给出一个顾及遥感图像多尺度和上下文注意力机制的描述生成模型框架,如图8-19所示。整个框架基于基本的编-解码架构,由基于深度学习的编码端和基于LSTM的解码端两部分组成。考虑到图像特征表达对于包括图像描述在内的计算机视觉任务至关重要,通过编码端获取遥感图像的多尺度特征表达和全局上下文特征表达,将其联合特征作为LSTM解码端的输入,以生成符合多尺度特性和上下文语境的描述语句。

图8-19 基于多尺度和上下文注意力机制的遥感图像描述生成框图

基于多尺度和上下文注意力机制的遥感图像描述生成算法的具体算法流程描述如下(参见图8-20):

(1)特征提取:首先,将原始遥感图像数据输入编码端,提取深度特征。这里采用VGG-16作为骨干网络来提取图像的视觉特征,提取的深度特征经过上采样后,传入注意力模块。

(2)多尺度特征表达:将不同网络层的特征图串联在一起,特征图通道中包含了不同层次的深度特征,将多尺度的深度表示嵌入到融合特征的不同通道中,以便利用通道注意和空间注意机制对不同尺度的特征进行自适应选择。其中,通道注意力用于学习具有不同尺度的选择性特征,而空间注意力机制用于增强网络对特定对象的聚焦。图像的多尺度特征可以由式(8.45)得到。

图8-20 基于多尺度和上下文注意力机制的遥感图像描述生成算法流程

其中,Ffc是全连接层特征;FL1和FL2分别表示VGG-16的conv4_3和conv5_3的特征图;Fml是用于描述生成的最终多尺度特征;α和β分别对应空间注意力权重和通道注意力权重;V表示卷积层特征图;Ws∈Rk×C,Whs∈Rk×d,Wi∈Rk是将图像视觉特征图和隐藏状态转换为同一维度的矩阵。

(3)全局上下文特征表达:图像上下文信息是图像的高级概念,可以通过上下文注意力机制挖掘图像周围潜在的上下文信息,具体模型如下式所述:

其中,FL1~FL5分别是VGG-16的卷积层conv1_3~conv5_3的特征图;a(·)为对齐模型;Wsh为维度调整因子;Wc可以改变上下文的权重,使属性可以聚焦于图像中的不同对象。

(4)描述语句生成:将多尺度特征和全局上下文特征联合起来,输入LSTM解码端,从而生成最终描述语句。LSTM解码端利用句子S={S1,S1,…,SL}、图像特征多尺度特征Fml和上下文信息F con依次生成描述遥感图像的词汇,LSTM解码端的计算定义如下:

(https://www.xing528.com)

(https://www.xing528.com)

最后,利用最小化交叉熵损失对LSTM进行训练。

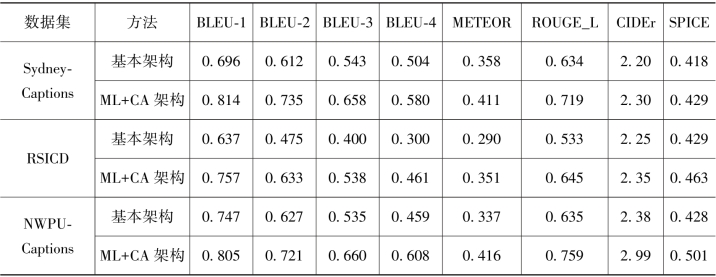

表8-5给出基于多尺度和上下文注意力机制的遥感图像描述生成算法在Sydney-Captions、UCM-Captions、RSICD和NWPU-Captions 4个数据集上的性能评价结果,评价指标采用BLEU、METEOR、ROUGE、CIDEr和SPICE。其中,采用经过了预训练的VGG-16作为特征提取的骨干网络,LSTM的隐藏层节点数为512个,并采用集束搜索(beam search),beam size大小为2。采用初始学习速率为×10-3的Adam优化器作为优化工具。对于“dropout”层,将“drop probability”设置为0.5。表8-5中,“基本架构”表示基本的编-解码架构,“ML+CA架构”表示在基本的编解码架构基础上,增加了多尺度模块(multilevel module)和上下文注意力模块(context attention module)部分。实验结果表明,增加对遥感图像多尺度和上下文注意力的特征表达,可以有效提高遥感图像描述生成算法的性能。

表8-5 基于多尺度和上下文注意力的遥感图像描述生成算法性能对比分析

续表

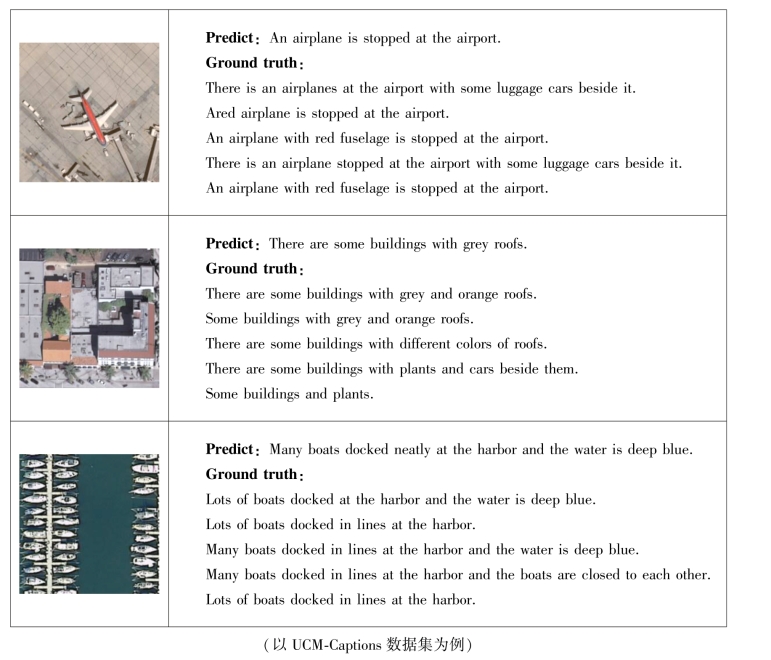

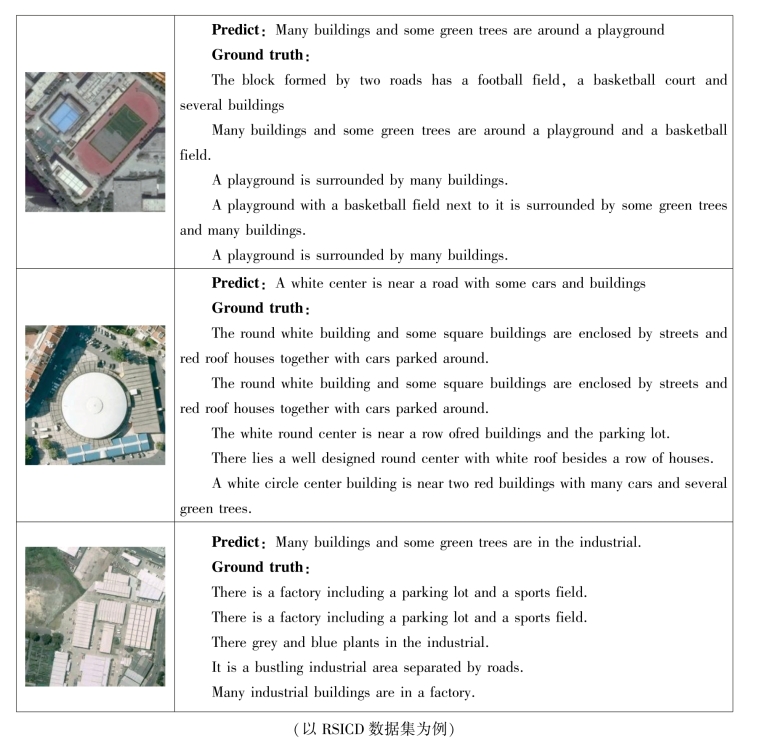

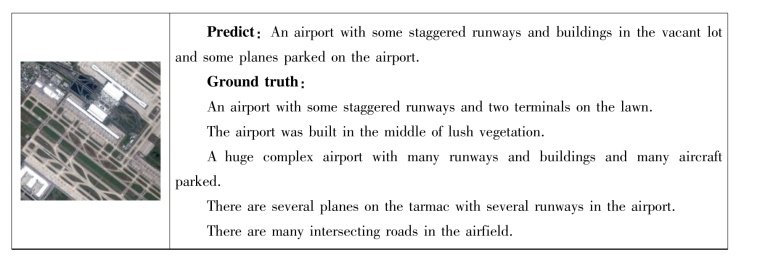

图8-21~图8-24分别给出基于多尺度和上下文注意力机制的遥感图像描述生成算法在Sydney-Captions、UCM-captions、RSICD和NWPU-Captions数据集上描述语句生成结果。其中类别属性标记为绿色,新颖的词汇标记为黄色,近义词标为蓝色,错词和漏词标为红色。可以看出,网络预测的结果与人工标注的GT保持了较好的语义一致性(类别属性正确),且词汇表达具有一定的新颖性。

图8-21 基于多尺度和上下文注意力机制的遥感图像描述生成结果

图8-22 基于多尺度和上下文注意力机制的遥感图像描述生成结果

图8-23 基于多尺度和上下文注意力机制的遥感图像描述生成结果

图8-24 基于多尺度和上下文注意力机制的遥感图像描述生成结果

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。