使用双目立体全景视觉系统进行实验,得到实际轨迹,并与无人驾驶车辆感知平台上其他传感器的数据进行对比,如表15-5 所示。

表15-5 公开数据集测试方案

因为并没有反射式全景视觉系统的数据集公开,而对于全景视觉系统来说,和普通相机的主要差异在于视场角的不同,因此在这一部分使用具有宽视场角相机的数据集进行评测,通过对比单目和双目情况下,宽视场角和窄视场角(为保持场景一致性,对宽视场角图像进行裁剪)下算法运行效果,如图15-20 所示。

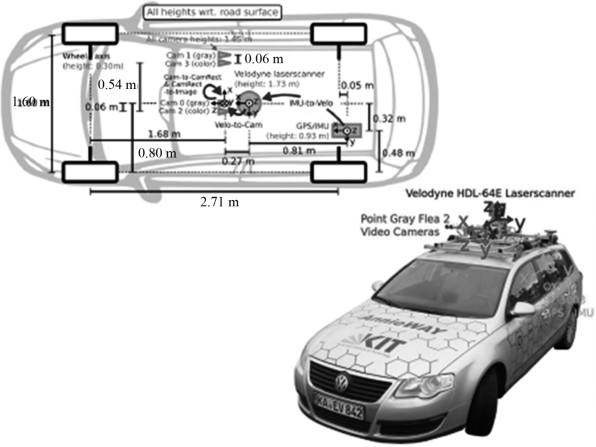

公开数据集测试部分使用Kitti 的OdomGray 数据集实验方案分别进行测试。Kitti 数据集是由德国卡尔斯鲁厄理工学院和丰田美国技术研究院联合创办,是目前国际上最大的自动驾驶场景下的计算机视觉算法评测数据集。其数据采集平台使用2 个黑白相机(PointGray Flea2)、2 个彩色相机(PointGray Flea2)、一个64 线激光雷达(Velodyne 64E)、一个卫星定位(L1/L2 RTK)与组合惯性导航设备(OXTSRT3003),激光雷达以及所有的相机都通过GPS 接收机进行精确的时间同步;Oxts 惯性导航设备通过接收GPS 的定位信息,融合自身的IMU 后输出与GPS 数据同步的导航信息,确保所有的传感器数据都是同步的,并且配备了磁盘阵列用来存储所有传感器的数据,如图15-21 所示。

图15-20 宽视场角和窄视场角场景示例

图15-21 车辆采集平台

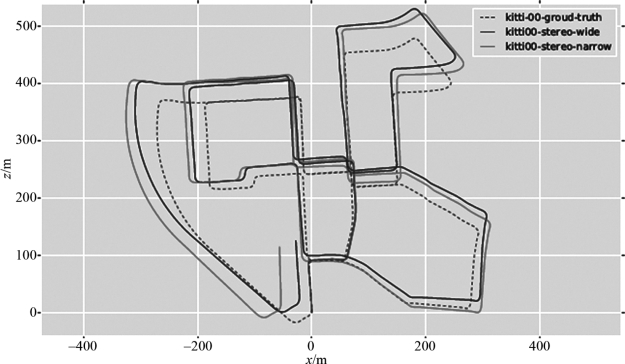

测试数据选择OdomGray-00(图15-22),共有4 541 对双目图像,在单目测试时只使用左相机的数据,数据内部包含了由高精度组合导航设备获取的位置点,作为车辆行驶的轨迹真值,统一称为GroundTruth。

使用双目DSO 算法对全分辨率OdomGray-00 数据集和经过裁剪的OdomGray-00 数据集进行测试。(https://www.xing528.com)

图15-22 Kitti Odom Gray00 数据集

1.全分辨率和半分辨率XZ 方向上轨迹图

图15-23 全分辨率与半分辨率图像在双目DSO 算法上运行轨迹图(见彩插)

双目DSO 由于引入了双目立体匹配技术,基线长度为系统提供了一个绝对的尺度信息,算法的运行轨迹也就可以和GroundTruth 进行对比分析。如图15-23 所示,黑色虚线为GroundTruth,蓝色实线为使用全分辨率图像运行算法的结果,绿色实线为使用半分辨率图像的结果。可以看出,相较于单目DSO,全分辨率的双目DSO 的运行轨迹可以接近闭合,受益于大视场角的影响,在一帧图像内可以同时观测到更多的地图点,同时在处理剧烈旋转等场景时,超宽的视场角可以在较长时刻内跟踪地图点,不会因为视野范围有限导致地图点过快地从视野中移出,从而可以获得更加稳定的定位效果。

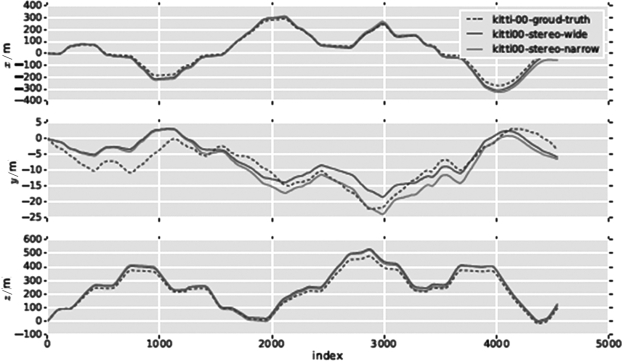

2.全分辨率和半分辨率XYZ 方向上误差图(图15-24)

应用双目视觉后,宽视场角的图像产生的蓝色轨迹相比绿色的半分辨率的图像产生的轨迹更好,双目立体相机的性能要远好于单目相机。相机种类相同的情况下,在直接法中使用宽视场角的图像所生成的轨迹更加贴近真实值,准确度更高。

图15-24 XYZ 方向误差图(见彩插)

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。