Christian Szegedy 等人在 ICLR 2014 发表的论文中提出了对抗样本(adversarial examples)的概念,即在数据集中通过故意添加细微的干扰来形成受干扰的输入样本,导致模型以高置信度给出错误输出。在他们的论文中,他们发现包括卷积神经网络(Convolutional Neural Network,CNN)在内的深度学习模型对于对抗样本都具有极高的脆弱性。他们提到,在很多情况下,在训练集的不同子集上训练得到的具有不同结构的模型都会对相同的对抗样本实现误分,这意味着对抗样本成为训练算法的一个盲点。Anh Nguyen 等人[18]在CVPR 2015 发表的论文中提到,他们发现对于一些人类完全无法识别的样本(论文中称为Fooling Examples),深度学习模型能以高置信度将它们进行分类。这些研究的提出,迅速吸引了公众的注意力,有人将其视为深度学习的深度缺陷,可是数据科学网站KDnuggets 上的一篇文章Deep Learning’s Deep Flaws 指出:事实上,深度学习对于对抗样本的脆弱性并不为深度学习独有,而是在很多的机器学习模型中普遍存在的,因此进一步研究有利于抵抗对抗样本的算法,将有利于整个机器学习领域的进步。

由此可见,深度神经网络在一些情况下是脆弱的,其脆弱性可能对用户(或应用)造成一定危害。在图像识别系统中,深度神经网络特别容易受到对抗样本的攻击。针对图像分类和目标检测领域[19-25],如果在人脸身份认证、自动驾驶等安全应用中,有利用对抗技术生成对抗样本进而进行欺骗行为的存在,那么将导致严重后果。对于人脸身份认证领域中的人脸支付或者人脸解锁应用,如果有恶意分子假冒当事人进行付款或者解锁手机,将造成当事人财产损失或隐私泄露;在自动驾驶领域中,如果有不法分子对交通标志牌做手脚,欺骗自动驾驶汽车,将导致汽车无法识别此标志牌或者将其错误分类,后果则不堪设想。为了防止此类欺骗行为,就需要深入研究神经网络脆弱的原因,以及对抗样本产生的内在机理。

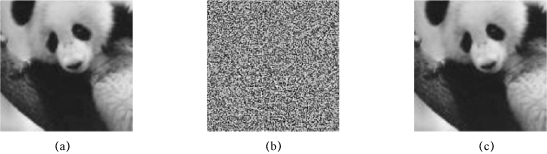

在深度神经网络中,研究以上欺骗行为的领域属于智能对抗领域。基于图像的智能对抗领域在近几年已成为深度学习领域的一个新研究方向,此领域中的欺骗行为是指对抗样本对分类模型的欺骗。干净样本是指自然得到的、没有经过刻意修饰的数据,如数据集 PASCAL VOC[26]、ImageNet[27]、COCO[28]中的样本。例如,在图 3 − 1 − 1 中,原始图像(干净样本)以57.7%的置信度被分类为panda,但添加扰动后,以99.3%的置信度被分类为gibbon;在图3 − 1 − 2 中,本来被分类为jay 的图像,在添加了肉眼无法察觉的扰动之后被模型错误地分类为mask。

图3−1−1 对抗样本示例 1[29]

(a)原始图像,以57.7%的置信度分类为panda;(b)噪声;(c)对抗样本,以99.3%的置信度分类为gibbon

(https://www.xing528.com)

(https://www.xing528.com)

图3−1−2 对抗样本示例 2

(a)原始图像,被分类为jay;(b)添加了肉眼无法察觉的扰动之后的对抗样本,被错误地分类为mask

图3 − 1 − 1 所示的panda 对抗样本是一个有针对性的(targeted)例子,也可以被称为靶向攻击。少量精心构造的噪声被添加到图像中,从而导致神经网络对图像进行错误的分类。然而,这个图像在人类看来与原始图像一样。还有一些无针对性(non − targeted)的例子,它们只是简单地尝试找到某个能蒙骗神经网络的输入,又被称为非靶向错分。对于人类而言,这种输入看起来可能像白噪声。但是,因为没有被限制为寻找对人而言类似某物的输入,所以这个问题要容易得多。

之所以深度神经网络中有对抗样本的存在,是因为其自身存在漏洞,从而使深度学习对于对抗样本表现出脆弱性。目前对这种脆弱性还没有一种完全令人信服的解释,无法获知确切原因。一种推断性的解释是深度神经网络的高度非线性特征,以及纯粹的监督学习模型中不充分的模型平均和不充分的正则化所导致的过拟合。但Goodfellow[29]在ICLR 2015 发表的论文中提出,通过在一个线性模型加入对抗干扰,只要线性模型的输入拥有足够的维度(事实上在大部分情况下,模型输入的维度都比较大,因为维度过小的输入会导致模型的准确率过低),线性模型就会对对抗样本表现出明显的脆弱性。这一结果否定了关于对抗样本是因为模型的高度非线性的说法;相反,其认为深度学习中对抗样本的存在是由于模型的线性特征。

关于对抗样本,有必要强调其中的一个重要概念——可转移性。可转移性是对抗样本的常见属性之一。Szegedy 等人[30]率先发现,一个基于神经网络生成的对抗样本可以欺骗使用不同数据集训练的相同的神经网络;Papernot 等人[31]发现,一个基于神经网络生成的对抗样本可以欺骗其他不同结构的神经网络,甚至可以欺骗那些使用不同机器学习算法训练过的分类器。可转移性的发现对于黑盒攻击具有重要意义,攻击者可以利用对抗样本的可转移性[32],在攻击目标模型之前选择一个白盒深度神经网络替代模型,并生成对抗样本来攻击这个替代模型。通过这种方式生成的对抗样本可以以一定概率来实现对黑盒模型的成功攻击。现阶段,在不同训练任务的所有不同神经网络之间的转移是难以发现的(例如,将目标检测的对抗样本转移到语义分析中)。现在已有许多研究人员通过对对抗样本的可转移性进行验证来演示对抗样本的性能。

对抗攻击的现象不是相对于某一种特殊的神经网络而存在的,相反,它是普遍存在的,其中包括典型的网络结构,如卷积神经网络、循环神经网络等。对抗样本的存在,对深度神经网络的发展起着积极作用;对抗样本的出现,指出了深度神经网络存在的漏洞。对抗样本要想成功欺骗深度神经网络,就必须用更先进的技术伪装自己;深度神经网络要想能够防御对抗样本,就要从各方面完善自身。双方博弈的最终结果是深度神经网络将变得更加鲁棒、成熟。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。