HDFS HA 安装准备步骤如下:

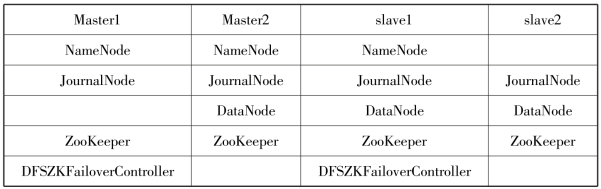

①Linux 系统安装。本节依旧使用VMware Workstation 14 并在其之上安装CentOS 7 64 位系统的方式来构建Hadoop 集群。虚拟机Linux 系统安装参考本书2.1 节。本章使用4 台虚拟机搭建HA 集群,节点master1 和slave1 作为NameNode,节点master2、slave1、slave2 作为DataNode,存储共享的JournalNode 在所有节点都要启动,具体节点服务规划见表6.2。

表6.2 节点服务规划表

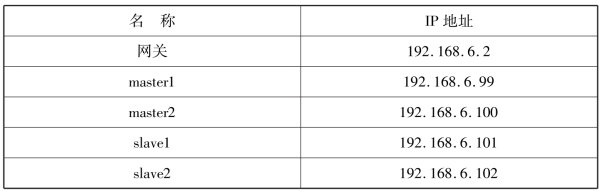

②Linux 系统网络配置。CentOS 系统安装完成后,为了使IP 地址固定,需要设置静态IP。首先规划IP 地址见表6.3。

表6.3 IP 地址规划表

(https://www.xing528.com)

(https://www.xing528.com)

③根据其IP 地址规划表对Linux 虚拟机进行配置修改,具体修改方法可参考本书2.2.1小节,修改之后任意两节点之间可以相互通信,可验证配置成功。

④修改所有节点的“/etc/hostname”文件,修改三个虚拟机的主机名,执行命令“vi /etc/hostname”,将原文件中的“localhost.localdomain”分别改为master1、master2、slave1 和slave2,修改完成后重启虚拟机。此时,可以看到主机名由原来的localhost 变成了对应的master1、master2、slave1 和slave2。具体修改方法参考本书2.2.2 小节,然后还要修改“/etc/hosts”文件,修改内容如图6.5 所示。

图6.5 hosts 文件内容

⑤创建普通用户“apache”,密码为“apache123”,配置方法参考本书2.3 节。

⑥后面的准备工作包括禁用防火墙、时钟同步、配置SSH 免密登录、JDK 安装与环境配置。配置方法与本书2.2 节方法相同。至此,HDFS HA 环境配置准备工作已经完成。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。