(1)向所有节点分发Hadoop 安装包

Hadoop 的配置文件修改完成后,将修改后的Hadoop 安装文件分发给各个子节点。

(2)修改所有节点的环境变量

修改三个节点的环境变量。在root 用户下执行命令“vi /etc/profile”,在文件中添加Hadoop 的环境变量,如图2. 50 所示。保存并退出后,执行“source /etc/profile”命令,使配置生效。

图2.50 添加Hadoop 环境变量

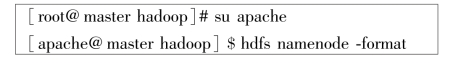

(3)格式化NameNode

切换到apache 用户,在master 节点执行NameNode 格式化操作,slave1 和slave2 节点不用格式化。需要特别注意的是,NameNode 不能多次格式化,否则会导致NameNode 和DataNode中的clusterID 值不一致,从而使得Hadoop 启动不正确。

(https://www.xing528.com)

(https://www.xing528.com)

(4)启动集群

在master 的终端执行命令“start-all. sh”启动Hadoop 集群,该命令可由“start-dfs. sh”和“start-yarn.sh”代替,用于分别启动HDFS 和YARN。首次启动Hadoop 时,会提示输入yes 或no,输入yes,第二次及以后启动不会输入任何内容。启动完成后,在三个节点的终端输入jps命令,如果出现如图2.51 至图2.53 所示的进程,则表示Hadoop 集群构建成功。

图2.51 master 进程

![]()

图2.52 slave1 进程

图2.53 slave2 进程

(5)关闭集群

在master 的终端中输入命令“stop-all. sh”,用于关闭整个Hadoop 集群,如果只是关闭HDFS,可使用“stop-hdfs.sh”命令。Hadoop 集群关闭后,在各个主机上通过jps 命令查看进程是否都正常关闭,如果还有“僵尸”进程存在,则使用kill 命令将其杀死。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。