如9.2节MIMO信道反馈模型所述,将LSTM-Attention CsiNet网络嵌入信道反馈模型中,可用于信道状态信息反馈。该网络是通过循环迭代的方式,以端对端的形式对上述两种信道反馈网络框架进行训练与优化,其优化的目标是使损失函数最小化,最终通过梯度下降的方法获得最优的网络核函数和最优的网络偏差,从而得到优化的神经网络。该训练过程中,采用均方误差作为损失函数来衡量重构性能,在每次迭代运算中,利用自适应矩估计优化算法更新神经网络中的训练参数。基于长短时-注意力机制的大规模MIMO信道反馈算法主要包括训练和反馈两个阶段。本节将以LSTM-Attention CsiNet为例,针对神经网络线上训练和线下反馈过程做出详细描述。

1.线下训练阶段

在用户端,经过信道估计模块处理得到的信道状态信息,经过DFT和截断的预处理操作,导入初始化神经网络的自动编码器模块,经过编码器提取特征信息以及压缩编码得到码字向量,通过上行反馈链路将码字向量发送至基站端。在基站端,接收到的压缩向量被传输到解码器,经过解压缩和信道恢复处理,恢复出信道状态信息。其中,需要说明的是,线下训练过程中,以系统估计值与实际值的MSE表示,即

其中:θe和θd分别为编码器和解码器的训练参数;fe和fd分别为编码器和解码器;K为batch_size;i为迭代次数。假设网络结构的输入为矩阵 ,网络的输出为信道状态信息矩阵

,网络的输出为信道状态信息矩阵 。综上所述,网络具体的训练过程如下。

。综上所述,网络具体的训练过程如下。

第二步:在用户端,将矩阵H′输入编码器。编码器中,首先通过卷积和重塑操作进行特征信息提取,将特征信息并行输入特征压缩模块的FCN和LSTM-Attention模块压缩成码字向量s。

第三步:将接收到的码字向量s通过上行链路传输至基站端。(https://www.xing528.com)

第四步:在基站端,将接收到的码字向量s输入解码器。首先,通过并行输入解压缩模块中的FCN和LSTM-Attention网络,将其解压缩成2Nt Nc×1的特征向量信息,随机输入信道恢复模块。

第五步:通过MSE计算损失函数L,ADAM算法更新网络中的训练参数值,其目的是减小原始有效矩阵H和估计矩阵 之间的损失。

之间的损失。

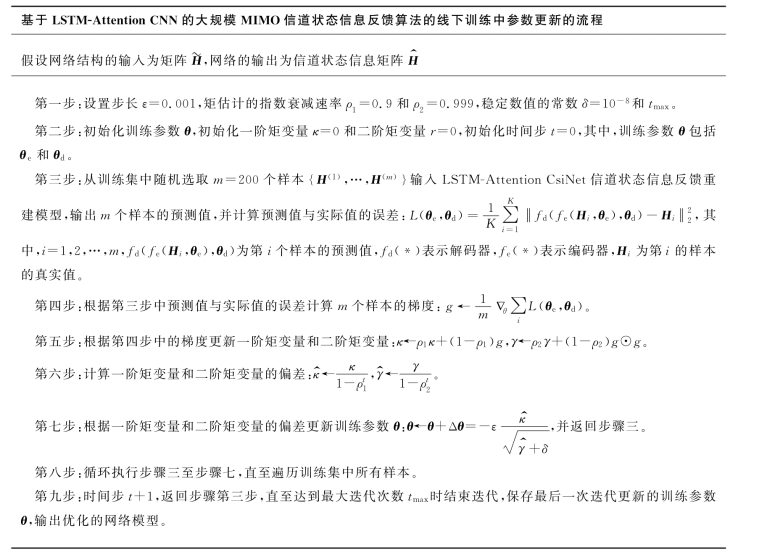

重复第二步至第四步进行循环迭代,直到获取最优的CSI反馈神经网络。迭代过程中使用ADAM梯度下降算法对参数进行更新,主要步骤如表9-1所示。

表9-1 训练参数更新流程

2.线上反馈阶段

首先,在用户端,可将估计的CSI导入最优神经网络的自动编码器模块,经过提取和压缩编码,将得到的码字向量发送到BS。然后,在BS中,接收到的码字向量依次通过解压缩和信道恢复处理,恢复出CSI,从而达到MIMO系统中信道反馈的效果。这种基于自动编码器的信道状态信息反馈方法,在线上反馈阶段,不需要额外的循环迭代计算操作,就可恢复出信道信息,有效地降低了信道反馈系统的计算复杂度。

本章所提出的两种网络框架LSTM-Attention CsiNet和Reduced LSTM-CsiNet都是通过同样的训练方法进行优化的。为了验证所提方法的信道反馈准确度和信道反馈算法的计算复杂度,将在下一节分别进行仿真实验。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。