深度学习是一种模仿人类神经网络结构和功能对事物进行认知学习以及解决复杂问题的方法。早在1958年,Frank等人首次提出了感知机模型。随后,越来越多的研究者致力于研究这种能够模仿生物感知的模型。其中,Marvin Minsky等人根据单层感知机提出多层感知机,并且验证了不仅单层感知机具有学习能力,多层感知机也具有学习能力。其中多层感知机是基于单层感知机升级得到的,即增加多个隐含层。此外,还提出了采用Sigmoid函数进行非线性映射来解决非线性问题。然而,因神经网络结构复杂导致在训练过程中需要很长的时间段,神经网络进入低谷期。直到Paul Werbos在1974年提出了误差反向传播算法,其训练时间勉强让人接受,由此神经网络进入新一轮热潮。但是,因为当时没有良好的神经网络框架,并且深层感知机的性能不如浅层感知机好,因此,神经网络又一次进入低潮期。

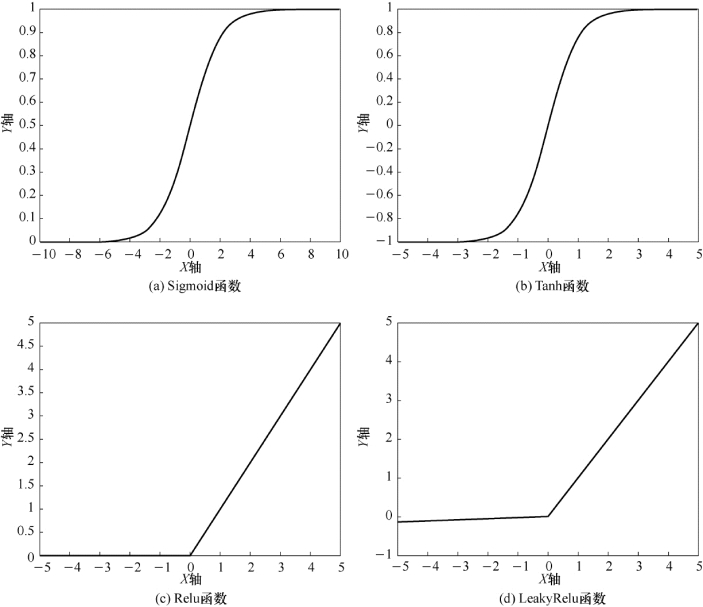

2006年,机器学习领域的专家Geoffrey Hinton及其团队针对机器学习问题提出两个重要的观点:一是相对于单层感知机,多层感知机具备更好的学习能力,从根本上学习事物的特征,多用于分类问题和可视化问题;二是为了优化多层感知机训练过程中耗时的问题,将训练转化为拆解逐层训练,并且引入了无监督学习方法。深度学习理论也正是在这一关键时期被Hinton等人提出的。这一重要理论再次掀起人工智能的狂潮,各个国家的科研工作者将深度学习的方法成功地引入各个领域,如图像处理、文本分类和自然语言处理等。随后,为了提升网络模型解决复杂问题的能力,各种深度学习神经网络模型相继被提出,如经典的卷积神经网络模型。卷积神经网络中的神经元之间是以局部连接的形式连接的,且每层进行组织图像转换,此外,相同的参数可直接应用于前一层网络的每一个不同位置,其网络结构形式的特点为平移不变性。除此之外,深度学习领域相关专家提出一些非线性激活函数,从而使网络模型可以更好地解决各种非线性问题,主要的非线性激活函数如图9-2所示,包括Sigmoid函数、Tanh函数、Relu函数、LeakyRelu函数等。(https://www.xing528.com)

图9-2 常用的激活函数

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。