(一)BP神经网络理论

神经网络或人工神经网络是在一定程度和层次上模仿了人脑神经网络系统的信息处理,利用大量的简单计算单元(神经元)构成的非线性系统。近期神经网络是随着计算机的计算能力发展而进一步发展的。

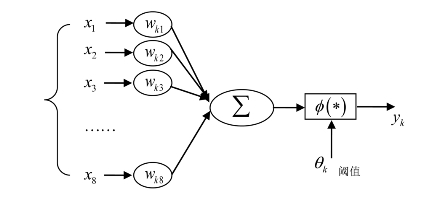

组成人工神经网络的三部分是人工神经元模型、人工神经网络的学习和网络的拓扑结构。神经元模型作为人工神经网络的基本单元,有以下三个基本的要素。

一是一组连接(对应于生物神经元的突触),连接强度由各连接上的权值表示,权值为正表示激活,为负表示抑制。

二是一个求和单元,用于求取各输入信号的加权和(线性组合)。

三是一个非线性激活函数,起非线性映射作用,并将神经元输出幅度限制在一定范围内,一般为(0,1)或(-1,1)。

图7-1 BP神经网络原理图

此外还有一个θk(或偏值bk=-θk)。以上可分别以数学形式表达出来:

其中,x1,x2,…,xn为输入信号;wk1,wk2,…,wkp为神经元k的权重;uk为线性组合结果;θk为阈值;φ(*)为激活函数;yk为神经元k的输出。

(二)BP网络训练参数介绍

BP网络是由非线性普通变换单元组成的前馈网络的简称。其算法的主要思想是,学习过程是由信号的正向传播与误差的反向传播两个过程组成,权值随着信号变化不断调整,这也就是所谓网络的学习训练过程。在此训练过程中,一直进行到网络输出的误差减少到可接受的程度或进行到预先设定的学习次数为止。[1]下面确定影响因素的人工神经网络模型的参数。

1.权重训练原理

当神经网络结构的权值确定后,神经网络构成从m维输入空间到n维输出空间的非线性映射。人工神经网络确定权重是基于一个隐层的3层BP网络,只要隐层节点足够多,就能够胜任任何精度逼近有界区域的连续函数。本书训练权重的思路是以现有的指标作为输入空间,通过对研究区选择城市样本构成训练样本集,前期权重作为输出空间,确定网络层数、各层的节点数以及学习参数。

2.网络层数的确定

理论上,具有单隐层的前馈网可以映射所有连续函数的规律已经得到证明,因此,降低训练误差可以通过增加隐层数来实现,这样还可以提高学习训练速度,当然相应地,网络结构也会变得比单层更加复杂。降低训练误差也同样可以通过增加网络的节点数来实现,其训练效果比增加层数更容易观察和调整。因此,为了减少训练误差,应优先考虑增加隐含层中的神经元节点数。本书就是主要采用具有单隐层的三层前馈网络。(https://www.xing528.com)

3.隐含层节点数的确定

输入输出单元的多少和输入输出单元的分布都与问题的要求、隐含层、节点数的确定有直接的关系。

隐含层节点数量过多,有可能把样本中非规律性的内容也学会记牢,如噪声;隐含层节点数量太少,网络从样本中获取的信息能力就差,不足以概括和体现训练集中的样本规模。如果出现“过度拟合”问题,反而会降低神经网络的泛化能力。此外,节点数太多还会增加训练时间。

本书采用试凑法确定隐含层节点数目,也即先设置较少的隐含层节点训练网络,然后逐渐增加隐含层节点数,网络误差最小时所对应的隐含层节点数就是最终满足要求的节点数目。

![]()

其中,L为隐含层节点数,数据最后取整;I为输入层节点数;O为输出层节点数;α为调节系数,α∈[0.5,1]。

4.激活函数的确定

根据对函数逼近的人工神经网络的特点分析,可知三层BP神经网络的隐藏层的激活函数为Sigmoidal函数,表达式如式(7-3)所示:

Sigmoidal函数是连续可微的,使得神经元的权值可用误差反向传播学习算法调节,对于输出层的激活函数是线性函数。

单极性S型函数属于非线性转移函数,它是实数域R到[0,1]闭集的非减连续函数,其特点是函数本身及其导数都是连续的,因此在处理上具有很大的便利性。与线性转移函数相比,其优点是不仅将离散的函数转化为连续型函数,而且还将函数收敛到[0,1],方便计算与检验。

5.期望误差的选取

在设计网络的训练过程中,期望误差值是可以用来终止网络训练的指标。因此,如果期望误差过小,则同一组数据训练次数过多,进而造成过拟合;而期望误差过大,则训练次数不够,导致其可靠性与应用价值不大。而且期望误差是否合适可以通过检测样本误差的大小来判断,如果不满足要求就重新训练网络,直到检测样本的误差满足要求。

本章首先运用传统的神经网络进行赋权,为了尽可能地提高赋权准确度,在本轮赋权过程中引入伯努利大数定理。神经网络随机赋权产生的结果,虽然有伯努利大数定理作为其理论依据,但实际操作过程中存在较大的漏洞。

(1)伯努利大数定理发生作用的前提条件是n足够大,但实际操作中这个n无法完全穷尽,即无法做到足够大。虽然本章在运行过程中是对随机产生的1000次结果取平均数,但1000次也无法表示足够大。

(2)由于1000次结果是随机产生的,即每一次运行的结果都不相同,不同的人运行的也不相同,其结果无法进行科学的预测,完全随机产生,结果无法令人信服。

因此,基于以上考虑,为了使神经网络运行结果更趋客观、合理,本章将对神经网络算法进行改良。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。